- 機器學習基礎

- ML - 首頁

- ML - 簡介

- ML - 入門

- ML - 基本概念

- ML - 生態系統

- ML - Python 庫

- ML - 應用

- ML - 生命週期

- ML - 必備技能

- ML - 實現

- ML - 挑戰與常見問題

- ML - 限制

- ML - 真實案例

- ML - 資料結構

- ML - 數學基礎

- ML - 人工智慧

- ML - 神經網路

- ML - 深度學習

- ML - 獲取資料集

- ML - 分類資料

- ML - 資料載入

- ML - 資料理解

- ML - 資料準備

- ML - 模型

- ML - 監督學習

- ML - 無監督學習

- ML - 半監督學習

- ML - 強化學習

- ML - 監督學習與無監督學習

- 機器學習資料視覺化

- ML - 資料視覺化

- ML - 直方圖

- ML - 密度圖

- ML - 箱線圖

- ML - 相關矩陣圖

- ML - 散點矩陣圖

- 機器學習統計學

- ML - 統計學

- ML - 均值、中位數、眾數

- ML - 標準差

- ML - 百分位數

- ML - 資料分佈

- ML - 偏度和峰度

- ML - 偏差和方差

- ML - 假設

- ML中的迴歸分析

- ML - 迴歸分析

- ML - 線性迴歸

- ML - 簡單線性迴歸

- ML - 多元線性迴歸

- ML - 多項式迴歸

- ML中的分類演算法

- ML - 分類演算法

- ML - 邏輯迴歸

- ML - K近鄰演算法 (KNN)

- ML - 樸素貝葉斯演算法

- ML - 決策樹演算法

- ML - 支援向量機

- ML - 隨機森林

- ML - 混淆矩陣

- ML - 隨機梯度下降

- ML中的聚類演算法

- ML - 聚類演算法

- ML - 基於質心的聚類

- ML - K均值聚類

- ML - K中心點聚類

- ML - 均值漂移聚類

- ML - 層次聚類

- ML - 基於密度的聚類

- ML - DBSCAN 聚類

- ML - OPTICS 聚類

- ML - HDBSCAN 聚類

- ML - BIRCH 聚類

- ML - 親和傳播

- ML - 基於分佈的聚類

- ML - 凝聚層次聚類

- ML中的降維

- ML - 降維

- ML - 特徵選擇

- ML - 特徵提取

- ML - 向後剔除法

- ML - 向前特徵構造

- ML - 高相關性過濾器

- ML - 低方差過濾器

- ML - 缺失值比率

- ML - 主成分分析

- 強化學習

- ML - 強化學習演算法

- ML - 利用與探索

- ML - Q學習

- ML - REINFORCE 演算法

- ML - SARSA 強化學習

- ML - 演員-評論家方法

- 深度強化學習

- ML - 深度強化學習

- 量子機器學習

- ML - 量子機器學習

- ML - 使用 Python 的量子機器學習

- 機器學習雜項

- ML - 效能指標

- ML - 自動工作流

- ML - 提升模型效能

- ML - 梯度提升

- ML - 自舉匯聚 (Bagging)

- ML - 交叉驗證

- ML - AUC-ROC 曲線

- ML - 網格搜尋

- ML - 資料縮放

- ML - 訓練和測試

- ML - 關聯規則

- ML - Apriori 演算法

- ML - 高斯判別分析

- ML - 成本函式

- ML - 貝葉斯定理

- ML - 精度和召回率

- ML - 對抗性

- ML - 堆疊

- ML - 輪次

- ML - 感知器

- ML - 正則化

- ML - 過擬合

- ML - P值

- ML - 熵

- ML - MLOps

- ML - 資料洩露

- ML - 機器學習的商業化

- ML - 資料型別

- 機器學習 - 資源

- ML - 快速指南

- ML - 速查表

- ML - 面試問題

- ML - 有用資源

- ML - 討論

機器學習 - 隨機森林

隨機森林是一種機器學習演算法,它使用決策樹的集合來進行預測。該演算法由 Leo Breiman 於 2001 年首次提出。該演算法背後的關鍵思想是建立大量的決策樹,每個決策樹都訓練於不同的資料子集。然後將這些單個樹的預測結果組合起來,以產生最終預測。

隨機森林演算法的工作原理

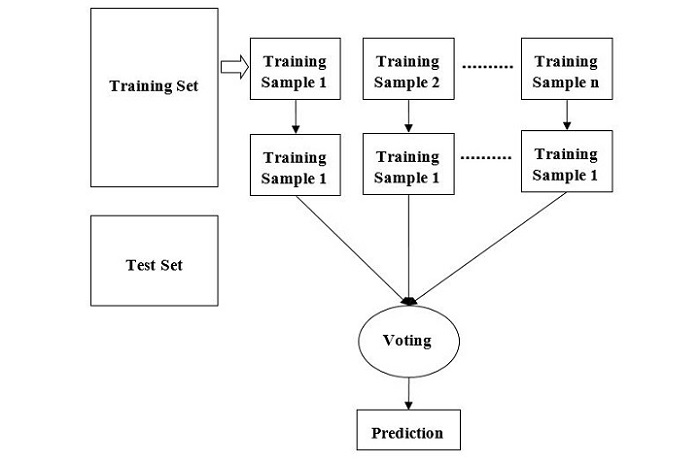

我們可以透過以下步驟來理解隨機森林演算法的工作原理:

步驟 1 - 首先,從給定的資料集中選擇隨機樣本。

步驟 2 - 接下來,該演算法將為每個樣本構建一棵決策樹。然後它將從每棵決策樹中獲取預測結果。

步驟 3 - 在此步驟中,將對每個預測結果進行投票。

步驟 4 - 最後,選擇得票最多的預測結果作為最終預測結果。

下圖說明了隨機森林演算法的工作原理:

隨機森林是一種靈活的演算法,可用於分類和迴歸任務。在分類任務中,該演算法使用各個樹預測結果的眾數來進行最終預測。在迴歸任務中,該演算法使用各個樹預測結果的平均值。

隨機森林演算法的優點

隨機森林演算法比其他機器學習演算法具有幾個優點。一些關鍵優勢包括:

對過擬合的魯棒性 - 隨機森林演算法以其對過擬合的魯棒性而聞名。這是因為該演算法使用決策樹的集合,這有助於減少資料中異常值和噪聲的影響。

高精度 - 隨機森林演算法以其高精度而聞名。這是因為該演算法結合了多個決策樹的預測結果,這有助於減少可能存在偏差或不準確的單個決策樹的影響。

處理缺失資料 - 隨機森林演算法可以處理缺失資料,無需進行插補。這是因為該演算法只考慮每個資料點可用的特徵,並且不需要所有資料點的所有特徵都存在。

非線性關係 - 隨機森林演算法可以處理特徵和目標變數之間的非線性關係。這是因為該演算法使用決策樹,可以模擬非線性關係。

特徵重要性 - 隨機森林演算法可以提供有關模型中每個特徵重要性的資訊。此資訊可用於識別資料中最重要的特徵,並可用於特徵選擇和特徵工程。

在 Python 中實現隨機森林演算法

讓我們來看一下在 Python 中實現隨機森林演算法的方法。我們將使用 scikit-learn 庫來實現該演算法。scikit-learn 庫是一個流行的機器學習庫,它提供了廣泛的機器學習演算法和工具。

步驟 1 - 匯入庫

我們將從匯入必要的庫開始。我們將使用 pandas 庫進行資料操作,並使用 scikit-learn 庫來實現隨機森林演算法。

import pandas as pd from sklearn.ensemble import RandomForestClassifier

步驟 2 - 載入資料

接下來,我們將資料載入到 pandas 資料框中。在本教程中,我們將使用著名的 Iris 資料集,這是一個用於分類任務的經典資料集。

# Loading the iris dataset

iris = pd.read_csv('https://archive.ics.uci.edu/ml/machine-learningdatabases/iris/iris.data', header=None)

iris.columns = ['sepal_length', 'sepal_width', 'petal_length','petal_width', 'species']

步驟 3 - 資料預處理

在我們使用資料訓練模型之前,我們需要對其進行預處理。這包括分離特徵和目標變數,並將資料分成訓練集和測試集。

# Separating the features and target variable X = iris.iloc[:, :-1] y = iris.iloc[:, -1] # Splitting the data into training and testing sets from sklearn.model_selection import train_test_split X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.35, random_state=42)

步驟 4 - 訓練模型

接下來,我們將使用訓練資料訓練我們的隨機森林分類器。

# Creating the Random Forest classifier object rfc = RandomForestClassifier(n_estimators=100) # Training the model on the training data rfc.fit(X_train, y_train)

步驟 5 - 進行預測

訓練完模型後,我們可以使用它對測試資料進行預測。

# Making predictions on the test data y_pred = rfc.predict(X_test)

步驟 6 - 評估模型

最後,我們將使用各種指標(如準確率、精確率、召回率和 F1 分數)來評估模型的效能。

# Importing the metrics library

from sklearn.metrics import accuracy_score, precision_score,

recall_score, f1_score

# Calculating the accuracy, precision, recall, and F1-score

accuracy = accuracy_score(y_test, y_pred)

precision = precision_score(y_test, y_pred, average='weighted')

recall = recall_score(y_test, y_pred, average='weighted')

f1 = f1_score(y_test, y_pred, average='weighted')

print("Accuracy:", accuracy)

print("Precision:", precision)

print("Recall:", recall)

print("F1-score:", f1)

完整的實現示例

以下是使用 iris 資料集在 python 中實現隨機森林演算法的完整實現示例:

import pandas as pd

from sklearn.ensemble import RandomForestClassifier

# Loading the iris dataset

iris = pd.read_csv('https://archive.ics.uci.edu/ml/machine-learningdatabases/iris/iris.data', header=None)

iris.columns = ['sepal_length', 'sepal_width', 'petal_length', 'petal_width', 'species']

# Separating the features and target variable

X = iris.iloc[:, :-1]

y = iris.iloc[:, -1]

# Splitting the data into training and testing sets

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y,

test_size=0.35, random_state=42)

# Creating the Random Forest classifier object

rfc = RandomForestClassifier(n_estimators=100)

# Training the model on the training data

rfc.fit(X_train, y_train)

# Making predictions on the test data

y_pred = rfc.predict(X_test)

# Importing the metrics library

from sklearn.metrics import accuracy_score, precision_score,

recall_score, f1_score

# Calculating the accuracy, precision, recall, and F1-score

accuracy = accuracy_score(y_test, y_pred)

precision = precision_score(y_test, y_pred, average='weighted')

recall = recall_score(y_test, y_pred, average='weighted')

f1 = f1_score(y_test, y_pred, average='weighted')

print("Accuracy:", accuracy)

print("Precision:", precision)

print("Recall:", recall)

print("F1-score:", f1)

輸出

這將給出我們隨機森林分類器的效能指標,如下所示:

Accuracy: 0.9811320754716981 Precision: 0.9821802935010483 Recall: 0.9811320754716981 F1-score: 0.9811157396063056