- 機器學習基礎

- ML - 首頁

- ML - 簡介

- ML - 入門

- ML - 基本概念

- ML - 生態系統

- ML - Python庫

- ML - 應用

- ML - 生命週期

- ML - 所需技能

- ML - 實現

- ML - 挑戰與常見問題

- ML - 限制

- ML - 真實案例

- ML - 資料結構

- ML - 數學基礎

- ML - 人工智慧

- ML - 神經網路

- ML - 深度學習

- ML - 獲取資料集

- ML - 分類資料

- ML - 資料載入

- ML - 資料理解

- ML - 資料預處理

- ML - 模型

- ML - 監督學習

- ML - 無監督學習

- ML - 半監督學習

- ML - 強化學習

- ML - 監督學習 vs. 無監督學習

- 機器學習資料視覺化

- ML - 資料視覺化

- ML - 直方圖

- ML - 密度圖

- ML - 箱線圖

- ML - 相關矩陣圖

- ML - 散點矩陣圖

- 機器學習統計學

- ML - 統計學

- ML - 均值、中位數、眾數

- ML - 標準差

- ML - 百分位數

- ML - 資料分佈

- ML - 偏度和峰度

- ML - 偏差與方差

- ML - 假設

- 機器學習中的迴歸分析

- ML - 迴歸分析

- ML - 線性迴歸

- ML - 簡單線性迴歸

- ML - 多元線性迴歸

- ML - 多項式迴歸

- 機器學習中的分類演算法

- ML - 分類演算法

- ML - 邏輯迴歸

- ML - K近鄰演算法 (KNN)

- ML - 樸素貝葉斯演算法

- ML - 決策樹演算法

- ML - 支援向量機

- ML - 隨機森林

- ML - 混淆矩陣

- ML - 隨機梯度下降

- 機器學習中的聚類演算法

- ML - 聚類演算法

- ML - 基於中心的聚類

- ML - K均值聚類

- ML - K中心點聚類

- ML - 均值漂移聚類

- ML - 層次聚類

- ML - 基於密度的聚類

- ML - DBSCAN聚類

- ML - OPTICS聚類

- ML - HDBSCAN聚類

- ML - BIRCH聚類

- ML - 親和傳播聚類

- ML - 基於分佈的聚類

- ML - 凝聚層次聚類

- 機器學習中的降維

- ML - 降維

- ML - 特徵選擇

- ML - 特徵提取

- ML - 向後剔除法

- ML - 向前特徵構建

- ML - 高相關性篩選

- ML - 低方差篩選

- ML - 缺失值比率

- ML - 主成分分析

- 強化學習

- ML - 強化學習演算法

- ML - 利用與探索

- ML - Q學習

- ML - REINFORCE演算法

- ML - SARSA強化學習

- ML - 演員-評論家方法

- 深度強化學習

- ML - 深度強化學習

- 量子機器學習

- ML - 量子機器學習

- ML - 使用Python的量子機器學習

- 機器學習雜項

- ML - 效能指標

- ML - 自動化工作流

- ML - 提升模型效能

- ML - 梯度提升

- ML - 自舉匯聚 (Bagging)

- ML - 交叉驗證

- ML - AUC-ROC曲線

- ML - 網格搜尋

- ML - 資料縮放

- ML - 訓練和測試

- ML - 關聯規則

- ML - Apriori演算法

- ML - 高斯判別分析

- ML - 成本函式

- ML - 貝葉斯定理

- ML - 精度和召回率

- ML - 對抗性

- ML - 堆疊

- ML - 輪次

- ML - 感知器

- ML - 正則化

- ML - 過擬合

- ML - P值

- ML - 熵

- ML - MLOps

- ML - 資料洩露

- ML - 機器學習的貨幣化

- ML - 資料型別

- 機器學習 - 資源

- ML - 快速指南

- ML - 速查表

- ML - 面試問題

- ML - 有用資源

- ML - 討論

Q學習

Q學習是一種基於值的強化學習演算法,它使模型能夠透過採取正確的行動來迭代學習和改進。正確的行動被認為是獎勵,而錯誤的行動則被認為是懲罰。

什麼是強化學習中的Q學習?

強化學習是一種機器學習方法,其中學習代理透過持續互動來學習如何在特定環境中做出正確的決策。在學習過程中,代理會在環境中經歷各種情況,這些情況被稱為“狀態”。代理在特定狀態下執行從可操作動作集中選擇的動作,這些動作會帶來獎勵或懲罰。隨著時間的推移,學習代理會學習最大化這些獎勵,以便在任何狀態下都能正確地行動。Q學習就是這樣一種演算法,它使用Q值(也稱為動作值)來迭代地改進學習代理的行為。

Q學習的關鍵組成部分

Q學習模型透過一個迭代過程執行,其中幾個元件協同工作來訓練模型。迭代過程包括代理透過探索環境進行學習並持續更新模型。Q學習包括以下元件:

- 代理 - 代理是在給定環境中執行和執行任務的實體。

- 狀態 - 狀態是一個變數,它指定代理在環境中的當前情況。

- 動作 - 代理在特定狀態下的行為。

- 獎勵 - 強化學習背後的思想是向代理的動作提供正面或負面的反饋。

- 回合 - 當代理達到無法再採取任何行動並終止的點時,就會發生一個回合。

- Q值 - Q值是用於評估特定狀態下動作的度量。

Q學習是如何工作的?

Q學習透過反覆試驗來學習代理在環境中執行的特定動作的結果。Q學習過程包括透過學習稱為Q函式的最優動作值函式來模擬最優行為。有兩種方法可以確定Q值:

時間差分

時間差分方程透過評估代理的當前狀態和動作以及之前的狀態和動作來確定Q值,從而確定差異。

時間差分可以表示為:

Q(s,a) = Q(s,a) + ɑ(r + γmaxaQ(s',a)-Q(s,a))

其中:

s 代表代理的當前狀態。

a 代表從Q表中選擇的當前動作。

s' 代表代理終止的下一個狀態。

a' 代表使用當前Q值估計選擇的下一個最佳動作。

r 代表環境對當前動作作出的當前獎勵。

γ ( &0 and <=1) 是未來獎勵的折扣因子。

ɑ 是用於更新Q(s,a)估計值的步長。

貝爾曼方程

數學家理查德·貝爾曼在1957年提出了這個方程,作為一種使用遞迴做出最優決策的方法。在Q學習的背景下,貝爾曼方程用於確定特定狀態的值並評估其相對位置。最優狀態由具有最高值的狀態確定。

貝爾曼方程可以表示為:

Q(s,a) = r(s,a) + ɑ maxaQ(s',a)

其中:

Q(s,a) 表示在狀態's'中採取動作'a'的預期獎勵。

R (s,a) 表示在狀態's'中執行動作a時獲得的獎勵。

ɑ 是折扣因子,表示未來獎勵的重要性。

maxaQ(s',a) 表示下一個狀態s'和所有可能動作的最大Q值。

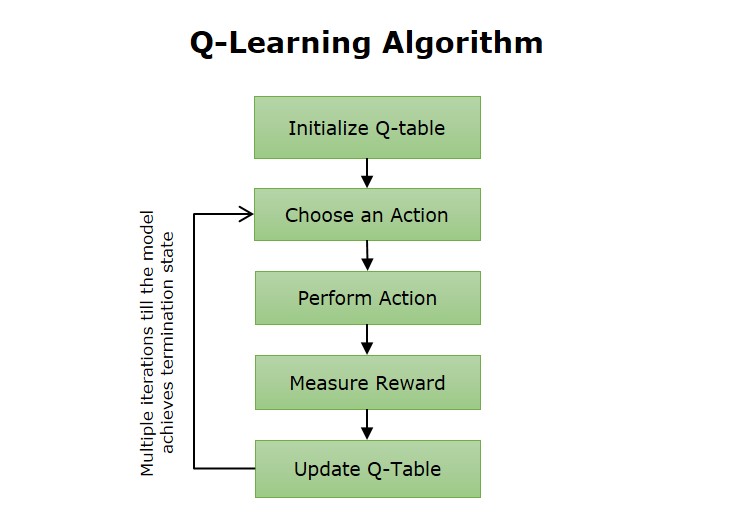

Q學習演算法

Q學習演算法涉及代理透過探索環境並根據收到的獎勵更新Q表來進行學習。Q表是一個儲存庫,用於儲存與給定環境中每個狀態的最優動作相關的獎勵。Q學習演算法過程中的步驟包括:

Q學習演算法的步驟如下:

- Q表的初始化 - 第一步涉及初始化Q表,以監控與在不同狀態下采取的動作相關的進度。

- 觀察 - 代理觀察環境的當前狀態。

- 行動 - 代理決定在環境中採取行動。完成後,模型會觀察該行動是否有助於環境。

- 更新 - 行動完成後,是時候使用結果更新Q表了。

- 重複 - 重複執行步驟2-4,直到模型達到終止狀態。

Q學習的優點

強化學習中的Q學習方法具有多種優勢,例如:

- 這種反覆試驗的學習方法類似於人們的學習方式,使其幾乎是理想的。

- 這種學習方法不依賴於策略,這使其能夠充分最佳化以獲得最佳結果。

- 這種無模型、非策略方法提高了在無法動態宣告引數的環境中工作的靈活性。

- 該模型能夠在訓練過程中糾正錯誤,並且再次發生已糾正錯誤的可能性非常小。

Q學習的缺點

強化學習中的Q學習方法也有一些缺點,例如:

- 對於這種方法來說,找到嘗試新動作和堅持已知內容之間的正確平衡是相當具有挑戰性的。

- Q學習模型有時會表現出過度樂觀,並高估特定動作或策略的有效性。

- 有時,當Q學習模型面臨多個問題解決選項時,確定最優策略會非常耗時。

Q學習的應用

Q學習模型可以改進各種場景中的過程。一些領域包括:

- 遊戲 - Q學習演算法可以透過學習最佳策略來提高遊戲系統的技能水平,使其達到各種遊戲的專家級水平。

- 推薦系統 - Q學習演算法可以用來改進推薦系統,例如廣告平臺。

- 機器人技術 - Q學習演算法使機器人能夠學習如何執行不同的任務,例如操縱物體、避開障礙物和運輸物品。

- 自動駕駛汽車 - Q學習演算法用於訓練自動駕駛汽車做出駕駛決策,例如換道或停車。

- 供應鏈 - Q學習模型可以透過最佳化產品進入市場的路徑來提高供應鏈的效率。