- TensorFlow 教程

- TensorFlow - 首頁

- TensorFlow - 簡介

- TensorFlow - 安裝

- 理解人工智慧

- 數學基礎

- 機器學習與深度學習

- TensorFlow - 基礎

- 卷積神經網路

- 迴圈神經網路

- TensorBoard 視覺化

- TensorFlow - 詞嵌入

- 單層感知器

- TensorFlow - 線性迴歸

- TFLearn 及其安裝

- CNN 和 RNN 的區別

- TensorFlow - Keras

- TensorFlow - 分散式計算

- TensorFlow - 匯出

- 多層感知器學習

- 感知器的隱藏層

- TensorFlow - 最佳化器

- TensorFlow - XOR 實現

- 梯度下降最佳化

- TensorFlow - 構建圖

- 使用 TensorFlow 進行影像識別

- 神經網路訓練建議

- TensorFlow 有用資源

- TensorFlow - 快速指南

- TensorFlow - 有用資源

- TensorFlow - 討論

神經網路訓練建議

本章將介紹可以使用 TensorFlow 框架實現的神經網路訓練的各個方面。

以下是十條可以評估的建議:

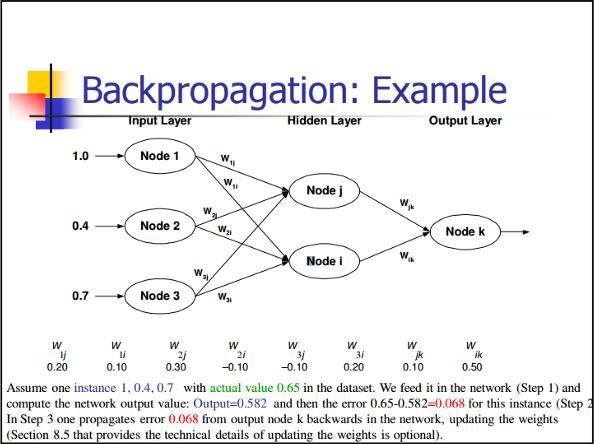

反向傳播

反向傳播是一種計算偏導數的簡單方法,它包括最適合神經網路的基本組合形式。

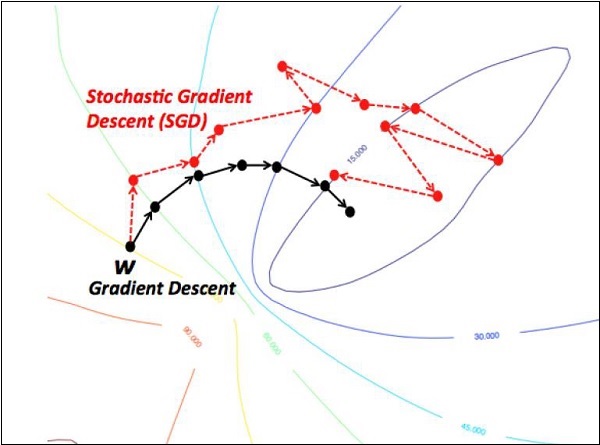

隨機梯度下降

在隨機梯度下降中,一個批次是使用者在單次迭代中用來計算梯度的示例總數。到目前為止,假設批次是整個資料集。最好的例子是在谷歌規模的工作;資料集通常包含數十億甚至數百億個示例。

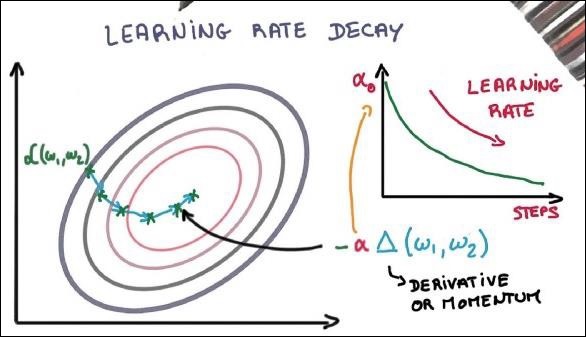

學習率衰減

調整學習率是梯度下降最佳化的最重要特性之一。這對於 TensorFlow 實現至關重要。

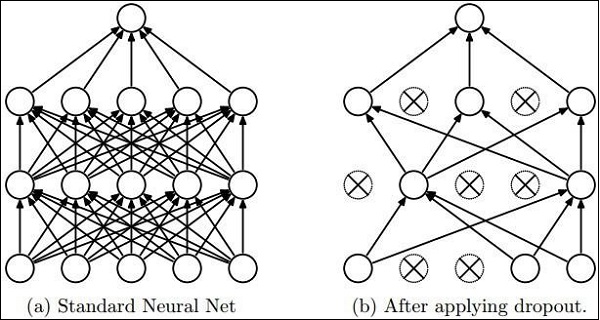

Dropout

具有大量引數的深度神經網路構成了強大的機器學習系統。但是,過擬合是此類網路中的一個嚴重問題。

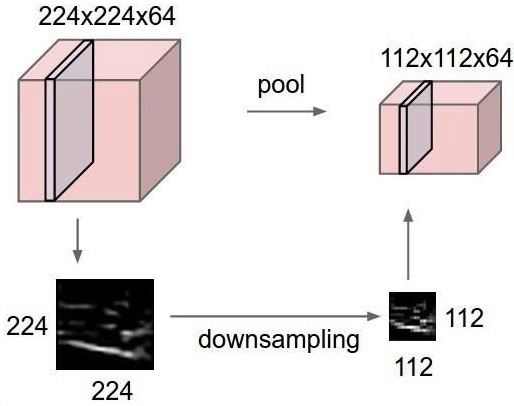

最大池化

最大池化是一種基於樣本的離散化過程。目的是對輸入表示進行下采樣,這在所需的假設下降低了維度。

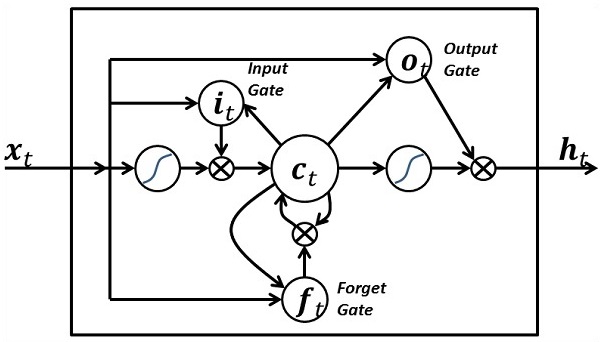

長短期記憶 (LSTM)

LSTM 控制著關於在指定神經元中應採用哪些輸入的決策。它包括控制哪些應該計算以及應該生成哪些輸出。

廣告