- 生成式AI教程

- 生成式AI - 首頁

- 生成式AI基礎

- 生成式AI基礎

- 生成式AI發展史

- 機器學習與生成式AI

- 生成式AI模型

- 判別式模型與生成式模型

- 生成式AI模型型別

- 機率分佈

- 機率密度函式

- 最大似然估計

- 生成式AI網路

- GAN的工作原理?

- GAN - 架構

- 條件GAN

- StyleGAN和CycleGAN

- 訓練GAN

- GAN應用

- 生成式AI Transformer

- Transformer在生成式AI中的應用

- Transformer在生成式AI中的架構

- Transformer中的輸入嵌入

- 多頭注意力機制

- 位置編碼

- 前饋神經網路

- Transformer中的殘差連線

- 生成式AI自編碼器

- 自編碼器在生成式AI中的應用

- 自編碼器型別及應用

- 使用Python實現自編碼器

- 變分自編碼器

- 生成式AI與ChatGPT

- 一個生成式AI模型

- 生成式AI雜項

- 生成式AI在製造業中的應用

- 生成式AI為開發者賦能

- 生成式AI在網路安全中的應用

- 生成式AI在軟體測試中的應用

- 生成式AI在市場營銷中的應用

- 生成式AI在教育領域的應用

- 生成式AI在醫療保健領域的應用

- 生成式AI為學生賦能

- 生成式AI在工業領域的應用

- 生成式AI在電影製作中的應用

- 生成式AI在音樂創作中的應用

- 生成式AI在烹飪領域的應用

- 生成式AI在媒體領域的應用

- 生成式AI在通訊領域的應用

- 生成式AI在攝影領域的應用

- 生成式AI資源

- 生成式AI - 有用資源

- 生成式AI - 討論

自編碼器在生成式AI中的應用

自編碼器是**機器學習**和**深度學習**領域中必不可少的工具。它們是一種特殊的無監督前饋神經網路,旨在學習資料的有效表示,用於降維、特徵提取和生成新資料。

自編碼器由兩個部分組成:編碼器網路和解碼器網路。編碼器網路充當壓縮單元,將輸入資料壓縮成低維表示。另一方面,解碼器網路透過重建來解壓縮壓縮的輸入資料。閱讀本章節,瞭解自編碼器、其架構、工作原理、訓練過程和超引數調整。

什麼是自編碼器?

專為無監督學習設計的自編碼器屬於**人工神經網路**的一種。與任何其他神經網路一樣,它由三種不同型別的層組成——輸入層、隱藏層和輸出層。輸入層中的輸入單元數量與輸出層中的輸出單元數量完全相同。但是,該網路中的中間層,即隱藏層,其單元數量少於輸入層和輸出層。

它首先將輸入資料壓縮成低維表示。由於隱藏層單元數量較少,因此它包含這種低維表示。最後,在輸出層,從這種簡化的輸入表示中重建輸出。

自編碼器也被稱為自監督機器學習模型,因為它們像監督機器學習模型一樣進行訓練,但在使用時,它們像無監督機器學習模型一樣工作。

自編碼器的架構

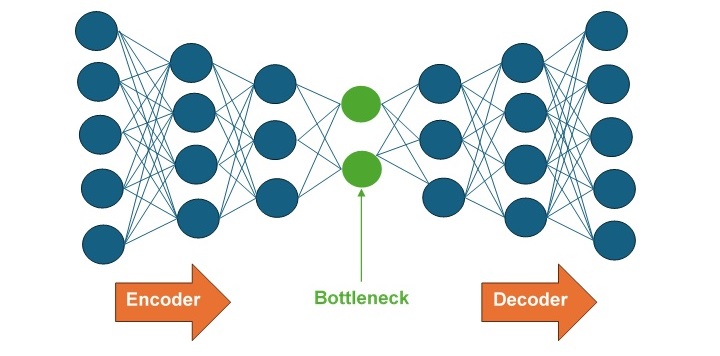

自編碼器的核心架構分為編碼器、解碼器和瓶頸層,如下圖所示:

- 編碼器 - 編碼器是一個全連線前饋神經網路 (FFNN),它將輸入資料壓縮成低維表示。

- 瓶頸層 - 瓶頸層包含輸入的低維表示,將被饋送到解碼器。

- 解碼器 - 解碼器是一個全連線前饋神經網路 (FFNN),它將輸入重建回原始維度。

自編碼器的工作原理

自編碼器工作原理的核心是訓練神經網路從低維表示中重建其輸入資料。這涉及兩個主要元件:編碼器網路和解碼器網路。

編碼器網路

編碼器網路將輸入壓縮成低維表示。此過程包括以下步驟:

- 輸入層 - 輸入資料透過輸入層饋入網路。

- 隱藏層 - 輸入資料現在透過多個隱藏層,其中每一層首先應用線性變換,然後應用非線性啟用函式。每一層的神經元數量都少於前一層,從而逐漸降低輸入資料的維度。

- 瓶頸層(潛在空間表示) - 瓶頸層是編碼器網路的最後一層,儲存輸入的壓縮表示。由於該層的維度遠低於輸入資料,因此它有助於網路學習輸入的最重要特徵。

解碼器網路

解碼器網路從低維表示中重建原始輸入資料。這個過程基本上是編碼過程的逆過程。它包括以下步驟:

- 瓶頸層(潛在空間表示) - 瓶頸層儲存的壓縮資料用作解碼器網路的輸入。

- 隱藏層 - 輸入資料現在透過多個隱藏層,其中每一層首先應用線性變換,然後應用非線性啟用函式。每一層的神經元數量都多於前一層,從而逐漸將輸入資料的維度擴充套件回原始輸入大小。

- 輸出層 - 輸出層是解碼器網路的最後一層,它重建資料以匹配原始輸入維度。

訓練過程

將網路訓練成從低維表示中重建其輸入資料,其過程包括以下步驟:

- 初始化 - 首先,網路的權重被隨機初始化。

- 前向傳播 - 在此步驟中,輸入資料首先透過編碼器轉換為低維資料,然後透過解碼器重建為原始資料。

- 損失計算 - 損失函式用於衡量原始輸入資料與其重建輸出之間的差異。一些常見的損失函式包括用於連續資料的均方誤差 (MSE) 或用於二元資料的二元交叉熵。

- 反向傳播 - 在此步驟中,為了最小化損失函式,網路會調整其權重。您可以使用梯度下降或任何其他最佳化演算法。

超引數調整

自編碼器中的超引數調整是選擇控制自編碼器工作方式的最佳引數集的過程。適當的超引數調整可以提高自編碼器的效率和準確性。

下面列出了一些需要考慮的關鍵超引數:

- 學習率 - 它決定了使用最佳化演算法最小化損失函式時的步長。較高的學習率可能導致更快的收斂,但穩定性較差。另一方面,較低的學習率可能導致收斂速度較慢,但穩定性更好。

- 批次大小 - 它指定每次迭代中使用的訓練樣本數量。較大的批次大小可以提供更精確的梯度估計,但需要更多記憶體和計算資源。

- 層數 - 它指定自編碼器架構的深度。更多層可以捕獲更復雜的特徵,但它們可能導致過擬合。

- 每層神經元數量 - 它決定每一層中的單元數量。每一層中更多的神經元可以學習更多細節,但這會增加模型的複雜性。

- 啟用函式 - 這些是應用於每一層輸出的數學函式。不同的啟用函式(如ReLU、Sigmoid、Tanh)會影響模型的效能。

結論

自編碼器將輸入資料壓縮成低維表示,然後從這種簡化的輸入表示中重建輸出。我們討論了自編碼器的工作原理及其架構。瞭解自編碼器的架構及其工作原理,機器學習從業者可以開啟資料分析的新可能性並提高模型效能。

我們還討論了自編碼器中的超引數調整。一些關鍵的超引數包括學習率、批次大小、層數、每層神經元數量和啟用函式。這些超引數的調整會影響自編碼器的效率和準確性。