- ChatGPT 教程

- ChatGPT - 首頁

- ChatGPT - 基礎知識

- ChatGPT - 入門指南

- ChatGPT - 工作原理

- ChatGPT - 提示詞

- ChatGPT - 競爭對手

- ChatGPT - 內容創作

- ChatGPT - 市場營銷

- ChatGPT - 求職者

- ChatGPT - 程式碼編寫

- ChatGPT - 搜尋引擎最佳化 (SEO)

- ChatGPT – 機器學習

- ChatGPT - 生成式AI

- ChatGPT - 構建聊天機器人

- ChatGPT - 外掛

- ChatGPT - GPT-4o (Omni)

- ChatGPT 有用資源

- ChatGPT - 快速指南

- ChatGPT - 有用資源

- ChatGPT - 討論

ChatGPT – 機器學習

賦予 ChatGPT 強大功能的基礎模型是什麼?

ChatGPT 的功能建立在機器學習的基礎之上,其關鍵貢獻來自監督學習、無監督學習和強化學習等型別。本章我們將瞭解機器學習如何促成 ChatGPT 的強大功能。

什麼是機器學習?

機器學習是人工智慧 (AI) 的一個動態領域,藉助它,計算機系統可以透過演算法或模型從原始資料中提取模式。這些演算法使計算機能夠自主地從經驗中學習,並進行預測或決策,而無需進行明確的程式設計。

現在,讓我們瞭解機器學習的型別及其在塑造 ChatGPT 功能方面的貢獻。

監督學習

監督學習是機器學習的一個類別,其中演算法或模型使用標記資料集進行訓練。在這種方法中,演算法被提供輸入-輸出對,其中每個輸入都與相應的輸出或標籤相關聯。監督學習的目標是使模型學習輸入和輸出之間的對映或關係,以便它能夠對新的、未見過的資料進行準確的預測或分類。

ChatGPT 使用監督學習來初步訓練其語言模型。在這個第一階段,語言模型使用包含輸入和輸出示例對的標記資料進行訓練。在 ChatGPT 的上下文中,輸入包含一部分文字,相應的輸出是對該文字的延續或響應。

這些帶註釋的資料幫助模型學習不同單詞、短語及其上下文相關性之間的關聯。ChatGPT 透過接觸各種示例,利用這些資訊來預測基於給定輸入最可能的下一個單詞或單詞序列。這就是監督學習成為 ChatGPT 理解和生成類似人類文字能力的基礎的方式。

無監督學習

無監督學習是一種機器學習方法,其中演算法或模型自主地分析和從資料中得出見解,無需標記示例的指導。簡而言之,這種方法的目標是在未標記資料中找到固有的模式、結構或關係。

監督學習為 ChatGPT 提供了堅實的基礎,但 ChatGPT 的真正魅力在於能夠創造性地生成連貫且上下文相關的答案或響應。這就是無監督學習發揮作用的地方。

藉助對各種網際網路文字進行的大規模預訓練,ChatGPT 發展出對事實、推理能力和語言模式的深刻理解。這就是無監督學習釋放 ChatGPT 的創造力並使其能夠對各種使用者輸入生成有意義的響應的方式。

強化學習

與監督學習相比,強化學習 (RL) 是一種機器學習正規化,其中智慧體透過與環境互動來學習決策。智慧體在環境中採取行動,以獎勵或懲罰的形式接收反饋,並利用此反饋隨著時間的推移改進其決策策略。

強化學習就像一個導航指南針,引導 ChatGPT 完成動態且不斷發展的對話。在最初的監督學習和無監督學習階段之後,模型會進行強化學習,以根據使用者反饋微調其響應。

大型語言模型 (LLM) 就像超級智慧工具,可以從海量文字中獲取知識。現在,想象一下,透過使用一種稱為強化學習的技術,使這些工具變得更智慧。這就像教它們將知識轉化為有用的行動。這種智力結合是基於人類反饋的強化學習 (RLHF) 背後的魔力,使這些語言模型在理解和響應我們方面更加出色。

基於人類反饋的強化學習 (RLHF)

2017 年,OpenAI 發表了一篇題為Deep reinforcement learning from human preferences 的研究論文,首次推出了基於人類反饋的強化學習 (RLHF)。有時我們需要在使用強化學習的情況下進行操作,但手頭的任務難以解釋。在這種情況下,人類反饋變得很重要,並且可以產生巨大的影響。

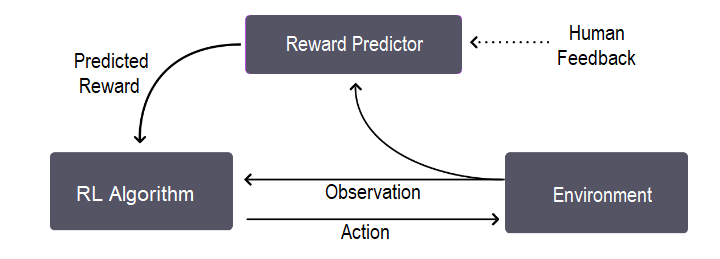

RLHF 透過加入少量的人類反饋來改進智慧體的學習過程。讓我們藉助此圖瞭解其整體訓練過程,這基本上是一個三步反饋迴圈:

正如我們在影像中看到的,反饋迴圈發生在智慧體對目標的理解、人類反饋和強化學習訓練之間。

RLHF 最初用於機器人技術等領域,已被證明可以提供更受控的使用者體驗。這就是為什麼 OpenAI、Meta、Google、亞馬遜網路服務、IBM、DeepMind、Anthropic 等主要公司已將其 RLHF 新增到其大型語言模型 (LLM) 中的原因。事實上,RLHF 已成為最流行的 LLM——ChatGPT 的關鍵組成部分。

ChatGPT 和 RLHF

在本節中,我們將解釋 ChatGPT 如何使用 RLHF 來適應人類反饋。

OpenAI 使用迴圈中的基於人類反饋的強化學習,即 RLHF,來訓練其InstructGPT 模型。在此之前,OpenAI API 由 GPT-3 語言模型驅動,該模型傾向於產生可能不真實且具有毒性的輸出,因為它們與使用者不一致。

另一方面,InstructGPT 模型比 GPT-3 模型要好得多,因為它們:

編造事實的頻率較低,並且

顯示出生成有害輸出的少量減少。

使用 RLHF 微調 ChatGPT 的步驟

對於 ChatGPT,OpenAI 採用了與InstructGPT 模型類似的方法,資料收集設定略有不同。

步驟 1:SFT(監督微調)模型

第一步主要涉及資料收集以訓練監督策略模型,稱為 SFT 模型。對於資料收集,選擇一組提示,然後要求一群人類標記者演示所需的輸出。

現在,ChatGPT 等多功能聊天機器人的開發人員決定使用來自 GPT-3.5 系列的預訓練模型,而不是微調原始 GPT-3 模型。換句話說,開發人員選擇在“程式碼模型”而不是純文字模型的基礎上進行微調。

此步驟生成的 SFT 模型的一個主要問題是其容易出現錯位,導致輸出缺乏使用者關注。

步驟 2:獎勵模型 (RM)

此步驟的主要目標是從資料中直接獲取目標函式。此目標函式為 SFT 模型輸出分配分數,反映其對人類的期望程度。

讓我們看看它是如何工作的:

首先,對提示列表和 SFT 模型輸出進行取樣。

然後,標記者將這些輸出從最好到最差進行排名。現在,資料集的大小是第一步中用於 SFT 模型的基線資料集的 10 倍。

新資料集現在用於訓練我們的獎勵模型 (RM)。

步驟 3:使用 PPO(近端策略最佳化)微調 SFT 策略

在此步驟中,應用了一種稱為近端策略最佳化 (PPO) 的特定強化學習演算法來微調 SFT 模型,使其能夠最佳化 RM。此步驟的輸出是一個名為 PPO 模型的微調模型。讓我們瞭解它是如何工作的:

首先,從資料集中選擇一個新的提示。

現在,初始化 PPO 模型以微調 SFT 模型。

此策略現在生成輸出,然後 RM 從該輸出計算獎勵。

然後,使用 PPO 使用此獎勵來更新策略。

結論

本章解釋了機器學習如何賦予 ChatGPT 強大的功能。我們還了解了機器學習正規化(監督學習、無監督學習和強化學習)如何幫助塑造 ChatGPT 的功能。

藉助 RLHF(基於人類反饋的強化學習),我們探討了人類反饋的重要性及其對 ChatGPT 等通用聊天機器人的效能的巨大影響。