- Beautiful Soup 教程

- Beautiful Soup - 首頁

- Beautiful Soup - 概述

- Beautiful Soup - 網頁抓取

- Beautiful Soup - 安裝

- Beautiful Soup - 解析頁面

- Beautiful Soup - 物件型別

- Beautiful Soup - 檢查資料來源

- Beautiful Soup - 抓取 HTML 內容

- Beautiful Soup - 透過標籤導航

- Beautiful Soup - 透過 ID 查詢元素

- Beautiful Soup - 透過 Class 查詢元素

- Beautiful Soup - 透過屬性查詢元素

- Beautiful Soup - 搜尋樹結構

- Beautiful Soup - 修改樹結構

- Beautiful Soup - 解析文件的一部分

- Beautiful Soup - 查詢元素的所有子元素

- Beautiful Soup - 使用 CSS 選擇器查詢元素

- Beautiful Soup - 查詢所有註釋

- Beautiful Soup - 從 HTML 中抓取列表

- Beautiful Soup - 從 HTML 中抓取段落

- BeautifulSoup - 從 HTML 中抓取連結

- Beautiful Soup - 獲取所有 HTML 標籤

- Beautiful Soup - 獲取標籤內的文字

- Beautiful Soup - 查詢所有標題

- Beautiful Soup - 提取標題標籤

- Beautiful Soup - 提取電子郵件 ID

- Beautiful Soup - 抓取巢狀標籤

- Beautiful Soup - 解析表格

- Beautiful Soup - 選擇第 n 個子元素

- Beautiful Soup - 透過標籤內的文字搜尋

- Beautiful Soup - 移除 HTML 標籤

- Beautiful Soup - 移除所有樣式

- Beautiful Soup - 移除所有指令碼

- Beautiful Soup - 移除空標籤

- Beautiful Soup - 移除子元素

- Beautiful Soup - find 與 find_all 的區別

- Beautiful Soup - 指定解析器

- Beautiful Soup - 比較物件

- Beautiful Soup - 複製物件

- Beautiful Soup - 獲取標籤位置

- Beautiful Soup - 編碼

- Beautiful Soup - 輸出格式化

- Beautiful Soup - 美化輸出

- Beautiful Soup - NavigableString 類

- Beautiful Soup - 將物件轉換為字串

- Beautiful Soup - 將 HTML 轉換為文字

- Beautiful Soup - 解析 XML

- Beautiful Soup - 錯誤處理

- Beautiful Soup - 故障排除

- Beautiful Soup - 移植舊程式碼

- Beautiful Soup - 函式參考

- Beautiful Soup - contents 屬性

- Beautiful Soup - children 屬性

- Beautiful Soup - string 屬性

- Beautiful Soup - strings 屬性

- Beautiful Soup - stripped_strings 屬性

- Beautiful Soup - descendants 屬性

- Beautiful Soup - parent 屬性

- Beautiful Soup - parents 屬性

- Beautiful Soup - next_sibling 屬性

- Beautiful Soup - previous_sibling 屬性

- Beautiful Soup - next_siblings 屬性

- Beautiful Soup - previous_siblings 屬性

- Beautiful Soup - next_element 屬性

- Beautiful Soup - previous_element 屬性

- Beautiful Soup - next_elements 屬性

- Beautiful Soup - previous_elements 屬性

- Beautiful Soup - find 方法

- Beautiful Soup - find_all 方法

- Beautiful Soup - find_parents 方法

- Beautiful Soup - find_parent 方法

- Beautiful Soup - find_next_siblings 方法

- Beautiful Soup - find_next_sibling 方法

- Beautiful Soup - find_previous_siblings 方法

- Beautiful Soup - find_previous_sibling 方法

- Beautiful Soup - find_all_next 方法

- Beautiful Soup - find_next 方法

- Beautiful Soup - find_all_previous 方法

- Beautiful Soup - find_previous 方法

- Beautiful Soup - select 方法

- Beautiful Soup - append 方法

- Beautiful Soup - extend 方法

- Beautiful Soup - NavigableString 方法

- Beautiful Soup - new_tag 方法

- Beautiful Soup - insert 方法

- Beautiful Soup - insert_before 方法

- Beautiful Soup - insert_after 方法

- Beautiful Soup - clear 方法

- Beautiful Soup - extract 方法

- Beautiful Soup - decompose 方法

- Beautiful Soup - replace_with 方法

- Beautiful Soup - wrap 方法

- Beautiful Soup - unwrap 方法

- Beautiful Soup - smooth 方法

- Beautiful Soup - prettify 方法

- Beautiful Soup - encode 方法

- Beautiful Soup - decode 方法

- Beautiful Soup - get_text 方法

- Beautiful Soup - diagnose 方法

- Beautiful Soup 有用資源

- Beautiful Soup 快速指南

- Beautiful Soup - 有用資源

- Beautiful Soup - 討論

Beautiful Soup 快速指南

Beautiful Soup - 概述

在當今世界,我們擁有大量非結構化資料/資訊(主要是網路資料)可供免費使用。有時這些免費資料易於閱讀,有時則不然。無論你的資料如何呈現,網頁抓取都是一個非常有用的工具,可以將非結構化資料轉換為更易於閱讀和分析的結構化資料。換句話說,網頁抓取是一種收集、整理和分析這些海量資料的方法。所以,讓我們首先了解什麼是網頁抓取。

Beautiful Soup 簡介

Beautiful Soup 是一個 Python 庫,其名稱來源於劉易斯·卡羅爾在《愛麗絲夢遊仙境》中同名的一首詩。Beautiful Soup 是一個 Python 包,顧名思義,它解析不需要的資料,並透過修復不良 HTML 並以易於遍歷的 XML 結構呈現給我們,從而幫助整理和格式化凌亂的網路資料。

簡而言之,Beautiful Soup 是一個 Python 包,它允許我們從 HTML 和 XML 文件中提取資料。

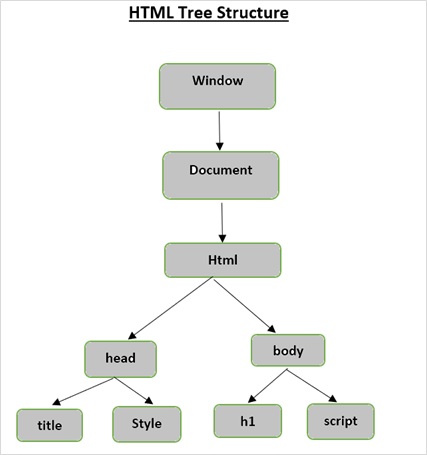

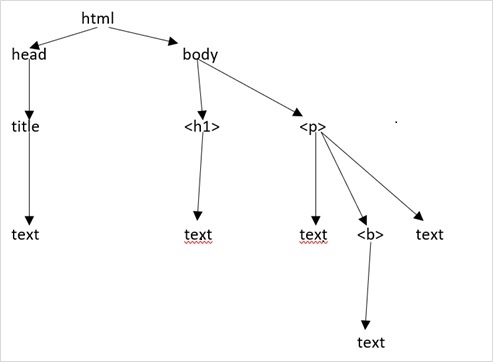

HTML 樹結構

在深入瞭解 Beautiful Soup 提供的功能之前,讓我們首先了解 HTML 樹結構。

文件樹中的根元素是 html,它可以有父節點、子節點和兄弟節點,這由它在樹結構中的位置決定。要在 HTML 元素、屬性和文字之間移動,必須在樹結構中的節點之間移動。

假設網頁如下所示:

它轉換為以下 HTML 文件:

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

</body>

</html>

這僅僅意味著,對於上面的 HTML 文件,我們有如下 HTML 樹結構:

Beautiful Soup - 網頁抓取

抓取僅僅是一個提取(從各種來源)、複製和篩選資料的過程。

當我們從網路(例如從網頁或網站)抓取或提取資料或 Feed 時,稱為網頁抓取。

因此,網頁抓取(也稱為網頁資料提取或網頁收集)是從網路中提取資料。簡而言之,網頁抓取為開發人員提供了一種從網際網路收集和分析資料的方法。

為什麼要進行網頁抓取?

網頁抓取提供了一種強大的工具來自動化人類在瀏覽時執行的大部分操作。企業以多種方式使用網頁抓取:

研究資料

智慧分析師(如研究人員或記者)使用網頁抓取器,而不是手動從網站收集和清理資料。

產品、價格和受歡迎程度比較

目前有一些服務使用網頁抓取器從眾多線上網站收集資料,並將其用於比較產品的受歡迎程度和價格。

SEO 監控

有許多 SEO 工具,如 Ahrefs、Seobility、SEMrush 等,用於競爭對手分析和從客戶網站提取資料。

搜尋引擎

一些大型 IT 公司的業務完全依賴於網頁抓取。

銷售和營銷

透過網頁抓取收集的資料可供營銷人員分析不同的細分市場和競爭對手,或供銷售專家用於銷售內容營銷或社交媒體推廣服務。

為什麼選擇 Python 進行網頁抓取?

Python 是最流行的網頁抓取語言之一,因為它可以非常輕鬆地處理大多數與網路爬取相關的任務。

以下是選擇 Python 進行網頁抓取的一些原因:

易用性

大多數開發人員都認為 Python 非常易於編碼。我們不必在任何地方使用花括號“{}”或分號“;” ,這使得它在開發網頁抓取器時更易於閱讀和使用。

強大的庫支援

Python 為不同的需求提供了大量的庫,因此它適用於網頁抓取以及資料視覺化、機器學習等。

易於理解的語法

Python 是一種非常易讀的程式語言,因為 Python 語法易於理解。Python 非常具有表現力,程式碼縮排幫助使用者區分程式碼中的不同塊或範圍。

動態型別語言

Python 是一種動態型別語言,這意味著分配給變數的資料會告訴我們它是什麼型別的變數。它節省了大量時間,並使工作更快。

龐大的社群

Python 社群非常龐大,無論你在編寫程式碼時遇到什麼問題,都可以獲得幫助。

Beautiful Soup - 安裝

Beautiful Soup 是一個庫,它簡化了從網頁抓取資訊的過程。它位於 HTML 或 XML 解析器的頂部,提供了 Python 風格的習慣用法來迭代、搜尋和修改解析樹。

BeautifulSoup 包不是 Python 標準庫的一部分,因此必須安裝它。在安裝最新版本之前,讓我們根據 Python 的推薦方法建立一個虛擬環境。

虛擬環境允許我們為特定專案建立 Python 的隔離工作副本,而不會影響外部設定。

我們將使用 Python 標準庫中的 venv 模組來建立虛擬環境。PIP 預設包含在 Python 3.4 或更高版本中。

使用以下命令在 Windows 上建立虛擬環境

C:\uses\user\>python -m venv myenv

在 Ubuntu Linux 上,在建立虛擬環境之前,如果需要,請更新 APT 儲存庫並安裝 venv

mvl@GNVBGL3:~ $ sudo apt update && sudo apt upgrade -y mvl@GNVBGL3:~ $ sudo apt install python3-venv

然後使用以下命令建立虛擬環境

mvl@GNVBGL3:~ $ sudo python3 -m venv myenv

你需要啟用虛擬環境。在 Windows 上使用以下命令

C:\uses\user\>cd myenv C:\uses\user\myenv>scripts\activate (myenv) C:\Users\users\user\myenv>

在 Ubuntu Linux 上,使用以下命令啟用虛擬環境

mvl@GNVBGL3:~$ cd myenv mvl@GNVBGL3:~/myenv$ source bin/activate (myenv) mvl@GNVBGL3:~/myenv$

虛擬環境的名稱顯示在括號中。現在它已啟用,我們可以在其中安裝 BeautifulSoup 了。

(myenv) mvl@GNVBGL3:~/myenv$ pip3 install beautifulsoup4

Collecting beautifulsoup4

Downloading beautifulsoup4-4.12.2-py3-none-any.whl (142 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

143.0/143.0 KB 325.2 kB/s eta 0:00:00

Collecting soupsieve>1.2

Downloading soupsieve-2.4.1-py3-none-any.whl (36 kB)

Installing collected packages: soupsieve, beautifulsoup4

Successfully installed beautifulsoup4-4.12.2 soupsieve-2.4.1

請注意,Beautifulsoup4 的最新版本是 4.12.2,需要 Python 3.8 或更高版本。

如果你沒有安裝 easy_install 或 pip,可以下載 Beautiful Soup 4 原始碼壓縮包並使用 setup.py 安裝它。

(myenv) mvl@GNVBGL3:~/myenv$ python setup.py install

要檢查 Beautifulsoup 是否已正確安裝,請在 Python 終端中輸入以下命令:

>>> import bs4 >>> bs4.__version__ '4.12.2'

如果安裝不成功,你將收到 ModuleNotFoundError 錯誤。

你還需要安裝 requests 庫。它是 Python 的 HTTP 庫。

pip3 install requests

安裝解析器

預設情況下,Beautiful Soup 支援 Python 標準庫中包含的 HTML 解析器,但它也支援許多外部第三方 Python 解析器,如 lxml 解析器或 html5lib 解析器。

要安裝 lxml 或 html5lib 解析器,請使用以下命令

pip3 install lxml pip3 install html5lib

這些解析器各有優缺點,如下所示:

解析器:Python 的 html.parser

用法 − BeautifulSoup(markup, "html.parser")

優點

- 內建

- 速度不錯

- 寬容(從 Python 3.2 開始)

缺點

- 速度不如 lxml,寬容度不如 html5lib。

解析器:lxml 的 HTML 解析器

用法 − BeautifulSoup(markup, "lxml")

優點

- 非常快

- 寬鬆的

缺點

-

外部 C 依賴

解析器:lxml 的 XML 解析器

用法 − BeautifulSoup(markup, "lxml-xml")

或 BeautifulSoup(markup, "xml")

優點

- 非常快

- 目前唯一支援的 XML 解析器

缺點

- 外部 C 依賴

解析器:html5lib

用法 − BeautifulSoup(markup, "html5lib")

優點

- 極其寬鬆

- 以與網路瀏覽器相同的方式解析頁面

- 建立有效的 HTML5

缺點

- 非常慢

- 外部 Python 依賴

Beautiful Soup - 解析頁面

現在是時候在一個 html 頁面中測試我們的 Beautiful Soup 包了(以網頁 - https://tutorialspoint.tw/index.htm 為例,您可以選擇任何其他網頁)並從中提取一些資訊。

在下面的程式碼中,我們嘗試從網頁中提取標題 -

示例

from bs4 import BeautifulSoup import requests url = "https://tutorialspoint.tw/index.htm" req = requests.get(url) soup = BeautifulSoup(req.content, "html.parser") print(soup.title)

輸出

<title>Online Courses and eBooks Library<title>

一個常見的任務是從網頁中提取所有 URL。為此,我們只需要新增下面的程式碼行 -

for link in soup.find_all('a'):

print(link.get('href'))

輸出

下面顯示了上述迴圈的部分輸出 -

https://tutorialspoint.tw/index.htm https://tutorialspoint.tw/codingground.htm https://tutorialspoint.tw/about/about_careers.htm https://tutorialspoint.tw/whiteboard.htm https://tutorialspoint.tw/online_dev_tools.htm https://tutorialspoint.tw/business/index.asp https://tutorialspoint.tw/market/teach_with_us.jsp https://#/tutorialspointindia https://www.instagram.com/tutorialspoint_/ https://twitter.com/tutorialspoint https://www.youtube.com/channel/UCVLbzhxVTiTLiVKeGV7WEBg https://tutorialspoint.tw/categories/development https://tutorialspoint.tw/categories/it_and_software https://tutorialspoint.tw/categories/data_science_and_ai_ml https://tutorialspoint.tw/categories/cyber_security https://tutorialspoint.tw/categories/marketing https://tutorialspoint.tw/categories/office_productivity https://tutorialspoint.tw/categories/business https://tutorialspoint.tw/categories/lifestyle https://tutorialspoint.tw/latest/prime-packs https://tutorialspoint.tw/market/index.asp https://tutorialspoint.tw/latest/ebooks … …

要解析本地當前工作目錄中儲存的網頁,請獲取指向 html 檔案的檔案物件,並將其用作 BeautifulSoup() 建構函式的引數。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup)

輸出

<html> <head> <title>Hello World</title> </head> <body> <h1 style="text-align:center;">Hello World</h1> </body> </html>

您還可以使用包含 HTML 指令碼的字串作為建構函式的引數,如下所示 -

from bs4 import BeautifulSoup

html = '''

<html>

<head>

<title>Hello World</title>

</head>

<body>

<h1 style="text-align:center;">Hello World</h1>

</body>

</html>

'''

soup = BeautifulSoup(html, 'html.parser')

print(soup)

Beautiful Soup 使用最佳可用的解析器來解析文件。除非另有指定,否則它將使用 HTML 解析器。

Beautiful Soup - 物件型別

當我們將 html 文件或字串傳遞給 beautifulsoup 建構函式時,beautifulsoup 基本上將複雜的 html 頁面轉換為不同的 python 物件。下面我們將討論 bs4 包中定義的四種主要型別的物件。

- 標籤

- 可導航字串

- BeautifulSoup

- 註釋

標籤物件

HTML 標籤用於定義各種型別的內容。BeautifulSoup 中的標籤物件對應於實際頁面或文件中的 HTML 或 XML 標籤。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<b class="boldest">TutorialsPoint</b>', 'lxml')

tag = soup.html

print (type(tag))

輸出

<class 'bs4.element.Tag'>

標籤包含許多屬性和方法,標籤的兩個重要特徵是其名稱和屬性。

名稱 (tag.name)

每個標籤都包含一個名稱,可以透過“.name”作為字尾來訪問。tag.name 將返回它所屬的標籤型別。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<b class="boldest">TutorialsPoint</b>', 'lxml')

tag = soup.html

print (tag.name)

輸出

html

但是,如果我們更改標籤名稱,則 BeautifulSoup 生成的 HTML 標記中也會反映出來。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<b class="boldest">TutorialsPoint</b>', 'lxml')

tag = soup.html

tag.name = "strong"

print (tag)

輸出

<strong><body><b class="boldest">TutorialsPoint</b></body></strong>

屬性 (tag.attrs)

一個標籤物件可以具有任意數量的屬性。在上面的示例中,標籤<b class="boldest">具有一個名為“class”的屬性,其值為“boldest”。任何不是標籤的東西,基本上都是一個屬性,並且必須包含一個值。“attrs”返回屬性及其值的字典。您也可以透過訪問鍵來訪問屬性。

在下面的示例中,Beautifulsoup() 建構函式的字串引數包含 HTML 輸入標籤。“attr”返回輸入標籤的屬性。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<input type="text" name="name" value="Raju">', 'lxml')

tag = soup.input

print (tag.attrs)

輸出

{'type': 'text', 'name': 'name', 'value': 'Raju'}

我們可以使用字典運算子或方法對標籤的屬性進行各種修改(新增/刪除/修改)。

在下面的示例中,更新了 value 標籤。更新後的 HTML 字串顯示了更改。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<input type="text" name="name" value="Raju">', 'lxml')

tag = soup.input

print (tag.attrs)

tag['value']='Ravi'

print (soup)

輸出

<html><body><input name="name" type="text" value="Ravi"/></body></html>

我們添加了一個新的 id 標籤,並刪除了 value 標籤。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<input type="text" name="name" value="Raju">', 'lxml')

tag = soup.input

tag['id']='nm'

del tag['value']

print (soup)

輸出

<html><body><input id="nm" name="name" type="text"/></body></html>

多值屬性

某些 HTML5 屬性可以具有多個值。最常用的是 class 屬性,它可以具有多個 CSS 值。其他包括“rel”、“rev”、“headers”、“accesskey”和“accept-charset”。Beautiful Soup 中的多值屬性顯示為列表。

示例

from bs4 import BeautifulSoup

css_soup = BeautifulSoup('<p class="body"></p>', 'lxml')

print ("css_soup.p['class']:", css_soup.p['class'])

css_soup = BeautifulSoup('<p class="body bold"></p>', 'lxml')

print ("css_soup.p['class']:", css_soup.p['class'])

輸出

css_soup.p['class']: ['body'] css_soup.p['class']: ['body', 'bold']

但是,如果任何屬性包含多個值,但它不是任何版本的 HTML 標準的多值屬性,則 Beautiful Soup 將保留該屬性 -

示例

from bs4 import BeautifulSoup

id_soup = BeautifulSoup('<p id="body bold"></p>', 'lxml')

print ("id_soup.p['id']:", id_soup.p['id'])

print ("type(id_soup.p['id']):", type(id_soup.p['id']))

輸出

id_soup.p['id']: body bold type(id_soup.p['id']): <class 'str'>

可導航字串物件

通常,某個字串放置在某種型別的開始和結束標籤中。瀏覽器的 HTML 引擎在呈現元素時會對字串應用預期的效果。例如,在<b>Hello World</b>中,您會在<b>和</b>標籤中間找到一個字串,以便以粗體顯示。

可導航字串物件表示標籤的內容。它是 bs4.element.NavigableString 類的物件。要訪問內容,請將標籤與“.string”一起使用。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>", 'html.parser')

print (soup.string)

print (type(soup.string))

輸出

Hello, Tutorialspoint! <class 'bs4.element.NavigableString'>

可導航字串物件類似於 Python Unicode 字串。它的一些功能支援遍歷樹和搜尋樹。可導航字串可以使用 str() 函式轉換為 Unicode 字串。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>",'html.parser')

tag = soup.h2

string = str(tag.string)

print (string)

輸出

Hello, Tutorialspoint!

就像 Python 字串是不可變的,可導航字串也不能就地修改。但是,使用 replace_with() 將標籤的內部字串替換為另一個字串。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>",'html.parser')

tag = soup.h2

tag.string.replace_with("OnLine Tutorials Library")

print (tag.string)

輸出

OnLine Tutorials Library

BeautifulSoup 物件

BeautifulSoup 物件表示整個已解析的物件。但是,可以認為它類似於 Tag 物件。當我們嘗試抓取 Web 資源時建立的物件。因為它類似於 Tag 物件,所以它支援解析和搜尋文件樹所需的功能。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

print (soup)

print (soup.name)

print ('type:',type(soup))

輸出

<html> <head> <title>TutorialsPoint</title> </head> <body> <h2>Departmentwise Employees</h2> <ul> <li>Accounts</li> <ul> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul> <li>Rani</li> <li>Ankita</li> </ul> </ul> </body> </html> [document] type: <class 'bs4.BeautifulSoup'>

BeautifulSoup 物件的 name 屬性始終返回 [document]。

如果將 BeautifulSoup 物件作為引數傳遞給某個函式(例如 replace_with()),則可以組合兩個已解析的文件。

示例

from bs4 import BeautifulSoup

obj1 = BeautifulSoup("<book><title>Python</title></book>", features="xml")

obj2 = BeautifulSoup("<b>Beautiful Soup parser</b>", "lxml")

obj2.find('b').replace_with(obj1)

print (obj2)

輸出

<html><body><book><title>Python</title></book></body></html>

註釋物件

HTML 和 XML 文件中<!-- 和 -->之間編寫的任何文字都被視為註釋。BeautifulSoup 可以將此類註釋文字檢測為 Comment 物件。

示例

from bs4 import BeautifulSoup markup = "<b><!--This is a comment text in HTML--></b>" soup = BeautifulSoup(markup, 'html.parser') comment = soup.b.string print (comment, type(comment))

輸出

This is a comment text in HTML <class 'bs4.element.Comment'>

Comment 物件是一種特殊型別的 NavigableString 物件。prettify() 方法以特殊格式顯示註釋文字 -

示例

print (soup.b.prettify())

輸出

<b> <!--This is a comment text in HTML--> </b>

Beautiful Soup - 檢查資料來源

為了使用 BeautifulSoup 和 Python 抓取網頁,任何 Web 抓取專案的第一步都應該是探索您想要抓取的網站。因此,首先訪問該網站以瞭解站點結構,然後開始提取與您相關的的資訊。

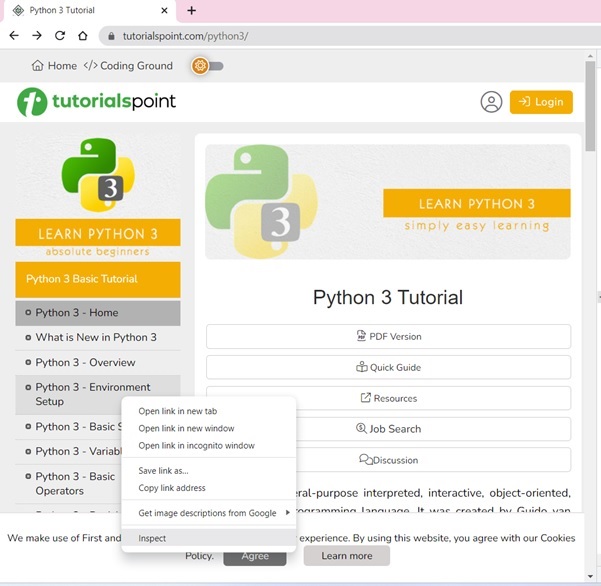

讓我們訪問 TutorialsPoint 的 Python 教程主頁。在瀏覽器中開啟https://tutorialspoint.tw/python3/index.htm。

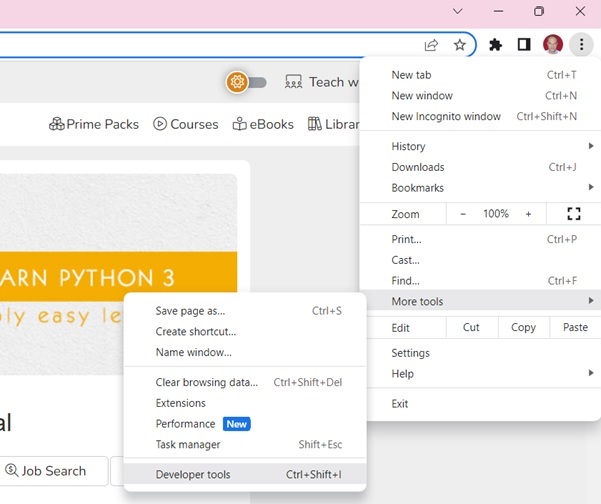

使用開發者工具可以幫助您瞭解網站的結構。所有現代瀏覽器都安裝了開發者工具。

如果使用 Chrome 瀏覽器,請從右上角選單按鈕 (⋮) 開啟開發者工具,然後選擇更多工具 → 開發者工具。

使用開發者工具,您可以瀏覽站點的文件物件模型 (DOM) 以更好地理解您的原始碼。在開發者工具中選擇“元素”選項卡。您將看到一個包含可點選 HTML 元素的結構。

教程頁面在左側邊欄中顯示了目錄。右鍵單擊任何章節,然後選擇“檢查”選項。

對於“元素”選項卡,找到對應於 TOC 列表的標籤,如下面的圖所示 -

右鍵單擊 HTML 元素,複製 HTML 元素,並將其貼上到任何編輯器中。

現在獲得了<ul>..</ul>元素的 HTML 指令碼。

<ul class="toc chapters"> <li class="heading">Python 3 Basic Tutorial</li> <li class="current-chapter"><a href="/python3/index.htm">Python 3 - Home</a></li> <li><a href="/python3/python3_whatisnew.htm">What is New in Python 3</a></li> <li><a href="/python3/python_overview.htm">Python 3 - Overview</a></li> <li><a href="/python3/python_environment.htm">Python 3 - Environment Setup</a></li> <li><a href="/python3/python_basic_syntax.htm">Python 3 - Basic Syntax</a></li> <li><a href="/python3/python_variable_types.htm">Python 3 - Variable Types</a></li> <li><a href="/python3/python_basic_operators.htm">Python 3 - Basic Operators</a></li> <li><a href="/python3/python_decision_making.htm">Python 3 - Decision Making</a></li> <li><a href="/python3/python_loops.htm">Python 3 - Loops</a></li> <li><a href="/python3/python_numbers.htm">Python 3 - Numbers</a></li> <li><a href="/python3/python_strings.htm">Python 3 - Strings</a></li> <li><a href="/python3/python_lists.htm">Python 3 - Lists</a></li> <li><a href="/python3/python_tuples.htm">Python 3 - Tuples</a></li> <li><a href="/python3/python_dictionary.htm">Python 3 - Dictionary</a></li> <li><a href="/python3/python_date_time.htm">Python 3 - Date & Time</a></li> <li><a href="/python3/python_functions.htm">Python 3 - Functions</a></li> <li><a href="/python3/python_modules.htm">Python 3 - Modules</a></li> <li><a href="/python3/python_files_io.htm">Python 3 - Files I/O</a></li> <li><a href="/python3/python_exceptions.htm">Python 3 - Exceptions</a></li> </ul>

我們現在可以將此指令碼載入到 BeautifulSoup 物件中以解析文件樹。

Beautiful Soup - 抓取 HTML 內容

從網站提取資料的過程稱為 Web 抓取。網頁可能包含 url、電子郵件地址、影像或任何其他內容,我們可以將其儲存在檔案或資料庫中。手動搜尋網站是一個繁瑣的過程。有不同的 Web 抓取工具可以自動化此過程。

有時,使用“robots.txt”檔案會禁止 Web 抓取。一些受歡迎的網站提供 API 以結構化的方式訪問其資料。不道德的 Web 抓取可能會導致您的 IP 被阻止。

Python 廣泛用於 Web 抓取。Python 標準庫具有 urllib 包,可用於從 HTML 頁面提取資料。由於 urllib 模組與標準庫捆綁在一起,因此無需安裝。

urllib 包是 Python 程式語言的 HTTP 客戶端。urllib.request 模組在我們想要開啟和讀取 URL 時很有用。urllib 包中的其他模組有 -

urllib.error 定義了 urllib.request 命令引發的異常和錯誤。

urllib.parse 用於解析 URL。

urllib.robotparser 用於解析 robots.txt 檔案。

使用 urllib 模組中的 urlopen() 函式從網站讀取網頁內容。

import urllib.request

response = urllib.request.urlopen('https://python.club.tw/')

html = response.read()

您也可以為此目的使用 requests 庫。您需要先安裝它才能使用。

pip3 install requests

在下面的程式碼中,抓取了https://tutorialspoint.tw的主頁 -

from bs4 import BeautifulSoup import requests url = "https://tutorialspoint.tw/index.htm" req = requests.get(url)

然後使用 Beautiful Soup 解析透過上述兩種方法中的任何一種獲得的內容。

Beautiful Soup - 透過標籤導航

任何 HTML 文件中重要的元素之一是標籤,它們可能包含其他標籤/字串(標籤的子元素)。Beautiful Soup 提供了不同的方法來導航和迭代標籤的子元素。

搜尋解析樹最簡單的方法是按名稱搜尋標籤。

soup.head

soup.head 函式返回放在 HTML 頁面<head> .. </head>元素內部的內容。

Consider the following HTML page to be scraped:

<html>

<head>

<title>TutorialsPoint</title>

<script>

document.write("Welcome to TutorialsPoint");

</script>

</head>

<body>

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

</body>

</html>

以下程式碼提取<head>元素的內容

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup.head)

輸出

<head>

<title>TutorialsPoint</title>

<script>

document.write("Welcome to TutorialsPoint");

</script>

</head>

soup.body

類似地,要返回 HTML 頁面的 body 部分的內容,請使用 soup.body

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print (soup.body)

輸出

<body> <h1>Tutorialspoint Online Library</h1> <p><b>It's all Free</b></p> </body>

您還可以提取<body>標籤中的特定標籤(如第一個<h1>標籤)。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup.body.h1)

輸出

<h1>Tutorialspoint Online Library</h1>

soup.p

我們的 HTML 檔案包含一個<p>標籤。我們可以提取此標籤的內容

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup.p)

輸出

<p><b>It's all Free</b></p>

Tag.contents

Tag 物件可能具有一個或多個 PageElements。Tag 物件的 contents 屬性返回其中包含的所有元素的列表。

讓我們在 index.html 檔案的<head>標籤中找到元素。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.head

print (tag.contents)

輸出

['\n',

<title>TutorialsPoint</title>,

'\n',

<script>

document.write("Welcome to TutorialsPoint");

</script>,

'\n']

Tag.children

HTML 指令碼中標籤的結構是分層的。元素巢狀在另一個元素內部。例如,頂級<HTML>標籤包含<HEAD>和<BODY>標籤,每個標籤都可能包含其他標籤。

Tag 物件具有一個 children 屬性,該屬性返回一個列表迭代器物件,其中包含封閉的 PageElements。

為了演示 children 屬性,我們將使用以下 HTML 指令碼 (index.html)。在<body>部分,有兩個<ul>列表元素,一個巢狀在另一個內部。換句話說,body 標籤具有頂級列表元素,每個列表元素在其下方都有另一個列表。

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<h2>Departmentwise Employees</h2>

<ul>

<li>Accounts</li>

<ul>

<li>Anand</li>

<li>Mahesh</li>

</ul>

<li>HR</li>

<ul>

<li>Rani</li>

<li>Ankita</li>

</ul>

</ul>

</body>

</html>

以下 Python 程式碼給出了頂級<ul>標籤的所有子元素的列表。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.ul

print (list(tag.children))

輸出

['\n', <li>Accounts</li>, '\n', <ul> <li>Anand</li> <li>Mahesh</li> </ul>, '\n', <li>HR</li>, '\n', <ul> <li>Rani</li> <li>Ankita</li> </ul>, '\n']

由於 .children 屬性返回一個列表迭代器,因此我們可以使用 for 迴圈來遍歷層次結構。

示例

for child in tag.children: print (child)

輸出

<li>Accounts</li> <ul> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul> <li>Rani</li> <li>Ankita</li> </ul>

Tag.find_all()

此方法返回與提供的引數標籤匹配的所有標籤內容的結果集。

讓我們考慮以下 HTML 頁面 (index.html) -

<html>

<body>

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

<a class="prog" href="https://tutorialspoint.tw/java/java_overview.htm" id="link1">Java</a>

<a class="prog" href="https://tutorialspoint.tw/cprogramming/index.htm" id="link2">C</a>

<a class="prog" href="https://tutorialspoint.tw/python/index.htm" id="link3">Python</a>

<a class="prog" href="https://tutorialspoint.tw/javascript/javascript_overview.htm" id="link4">JavaScript</a>

<a class="prog" href="https://tutorialspoint.tw/ruby/index.htm" id="link5">C</a>

</body>

</html>

以下程式碼列出了所有具有<a>標籤的元素

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

result = soup.find_all("a")

print (result)

輸出

[ <a class="prog" href="https://tutorialspoint.tw/java/java_overview.htm" id="link1">Java</a>, <a class="prog" href="https://tutorialspoint.tw/cprogramming/index.htm" id="link2">C</a>, <a class="prog" href="https://tutorialspoint.tw/python/index.htm" id="link3">Python</a>, <a class="prog" href="https://tutorialspoint.tw/javascript/javascript_overview.htm" id="link4">JavaScript</a>, <a class="prog" href="https://tutorialspoint.tw/ruby/index.htm" id="link5">C</a> ]

Beautiful Soup - 透過 ID 查詢元素

在 HTML 文件中,通常每個元素都分配一個唯一的 ID。這使得可以透過前端程式碼(如 JavaScript 函式)提取元素的值。

使用 BeautifulSoup,您可以透過其 ID 找到給定元素的內容。可以透過兩種方法實現此目的 - find() 和 find_all(),以及 select()

使用 find() 方法

BeautifulSoup 物件的 find() 方法搜尋第一個滿足作為引數給定條件的元素。

讓我們為此目的使用以下 HTML 指令碼(作為 index.html)

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<form>

<input type = 'text' id = 'nm' name = 'name'>

<input type = 'text' id = 'age' name = 'age'>

<input type = 'text' id = 'marks' name = 'marks'>

</form>

</body>

</html>

以下 Python 程式碼查詢其 id 為 nm 的元素

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find(id = 'nm')

print (obj)

輸出

<input id="nm" name="name" type="text"/>

使用 find_all()

find_all() 方法也接受一個 filter 引數。它返回具有給定 id 的所有元素的列表。在某些 HTML 文件中,通常只有一個具有特定 id 的元素。因此,使用 find() 而不是 find_all() 更適合搜尋給定的 id。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find_all(id = 'nm')

print (obj)

輸出

[<input id="nm" name="name" type="text"/>]

請注意,find_all() 方法返回一個列表。find_all() 方法還有一個 limit 引數。將 find_all() 的 limit 設定為 1 等效於 find()

obj = soup.find_all(id = 'nm', limit=1)

使用 select() 方法

BeautifulSoup 類中的 select() 方法接受 CSS 選擇器作為引數。# 符號是 id 的 CSS 選擇器。它後面跟著所需 id 的值傳遞給 select() 方法。它的作用與 find_all() 方法相同。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select("#nm")

print (obj)

輸出

[<input id="nm" name="name" type="text"/>]

使用 select_one()

與 find_all() 方法類似,select() 方法也返回一個列表。還有一個 select_one() 方法用於返回給定引數的第一個標籤。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select_one("#nm")

print (obj)

輸出

<input id="nm" name="name" type="text"/>

Beautiful Soup - 透過 Class 查詢元素

CSS(層疊樣式表)是用於設計 HTML 元素外觀的工具。CSS 規則控制 HTML 元素的不同方面,例如大小、顏色、對齊方式等。應用樣式比定義 HTML 元素屬性更有效。您可以將樣式規則應用於每個 HTML 元素。與其分別對每個元素應用樣式,不如使用 CSS 類將類似的樣式應用於 HTML 元素組,以實現統一的網頁外觀。在 BeautifulSoup 中,可以找到使用 CSS 類設定樣式的標籤。在本章中,我們將使用以下方法搜尋指定 CSS 類的元素:

- find_all() 和 find() 方法

- select() 和 select_one() 方法

CSS 中的類

CSS 中的類是指定與外觀相關的不同特徵(例如字型型別、大小和顏色、背景顏色、對齊方式等)的屬性的集合。宣告類時,類名字首為點(.)。

.class {

css declarations;

}

CSS 類可以內聯定義,也可以在需要包含在 HTML 指令碼中的單獨 css 檔案中定義。CSS 類的典型示例如下:

.blue-text {

color: blue;

font-weight: bold;

}

您可以藉助以下 BeautifulSoup 方法搜尋使用特定類樣式定義的 HTML 元素。

出於本章的目的,我們將使用以下 HTML 頁面:

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<h2 class="heading">Departmentwise Employees</h2>

<ul>

<li class="mainmenu">Accounts</li>

<ul>

<li class="submenu">Anand</li>

<li class="submenu">Mahesh</li>

</ul>

<li class="mainmenu">HR</li>

<ul>

<li class="submenu">Rani</li>

<li class="submenu">Ankita</li>

</ul>

</ul>

</body>

</html>

使用 find() 和 find_all()

要搜尋標籤中使用的特定 CSS 類的元素,請使用 Tag 物件的attrs 屬性,如下所示:

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find_all(attrs={"class": "mainmenu"})

print (obj)

輸出

[<li class="mainmenu">Accounts</li>, <li class="mainmenu">HR</li>]

結果是所有具有 mainmenu 類的元素的列表

要獲取 attrs 屬性中提到的任何 CSS 類的元素列表,請將 find_all() 語句更改為:

obj = soup.find_all(attrs={"class": ["mainmenu", "submenu"]})

這將生成一個包含上面使用的任何 CSS 類的所有元素的列表。

[ <li class="mainmenu">Accounts</li>, <li class="submenu">Anand</li>, <li class="submenu">Mahesh</li>, <li class="mainmenu">HR</li>, <li class="submenu">Rani</li>, <li class="submenu">Ankita</li> ]

使用 select() 和 select_one()

您還可以使用 select() 方法,並將 CSS 選擇器作為引數。點(.) 符號後跟類名用作 CSS 選擇器。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select(".heading")

print (obj)

輸出

[<h2 class="heading">Departmentwise Employees</h2>]

select_one() 方法返回使用給定類找到的第一個元素。

obj = soup.select_one(".submenu")

Beautiful Soup - 透過屬性查詢元素

find() 和 find_all() 方法都旨在根據傳遞給這些方法的引數查詢文件中一個或所有標籤。您可以將 attrs 引數傳遞給這些函式。attrs 的值必須是一個字典,其中包含一個或多個標籤屬性及其值。

為了檢查這些方法的行為,我們將使用以下 HTML 文件 (index.html)

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<form>

<input type = 'text' id = 'nm' name = 'name'>

<input type = 'text' id = 'age' name = 'age'>

<input type = 'text' id = 'marks' name = 'marks'>

</form>

</body>

</html>

使用 find_all()

以下程式返回所有具有 input type="text" 屬性的標籤的列表。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find_all(attrs={"type":'text'})

print (obj)

輸出

[<input id="nm" name="name" type="text"/>, <input id="age" name="age" type="text"/>, <input id="marks" name="marks" type="text"/>]

使用 find()

find() 方法返回已解析文件中第一個具有給定屬性的標籤。

obj = soup.find(attrs={"name":'marks'})

使用 select()

select() 方法可以透過將要比較的屬性作為引數來呼叫。屬性必須放在列表物件中。它返回所有具有給定屬性的標籤的列表。

在以下程式碼中,select() 方法返回所有具有 type 屬性的標籤。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select("[type]")

print (obj)

輸出

[<input id="nm" name="name" type="text"/>, <input id="age" name="age" type="text"/>, <input id="marks" name="marks" type="text"/>]

使用 select_one()

select_one() 方法與此類似,只是它返回滿足給定過濾器的第一個標籤。

obj = soup.select_one("[name='marks']")

輸出

<input id="marks" name="marks" type="text"/>

Beautiful Soup - 搜尋樹結構

在本章中,我們將討論 Beautiful Soup 中的不同方法,用於以不同方向遍歷 HTML 文件樹——向上和向下、左右以及來回。

我們將在本章的所有示例中使用以下 HTML 字串:

html = """

<html><head><title>TutorialsPoint</title></head>

<body>

<p class="title"><b>Online Tutorials Library</b></p>

<p class="story">TutorialsPoint has an excellent collection of tutorials on:

<a href="https://tutorialspoint.tw/Python" class="lang" id="link1">Python</a>,

<a href="https://tutorialspoint.tw/Java" class="lang" id="link2">Java</a> and

<a href="https://tutorialspoint.tw/PHP" class="lang" id="link3">PHP</a>;

Enhance your Programming skills.</p>

<p class="tutorial">...</p>

"""

所需標籤的名稱允許您導航解析樹。例如 soup.head 將為您獲取 <head> 元素:

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') print (soup.head.prettify())

輸出

<head>

<title>

TutorialsPoint

</title>

</head>

向下

一個標籤可能包含在其內封閉的字串或其他標籤。Tag 物件的 .contents 屬性返回屬於它的所有子元素的列表。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.head print (list(tag.children))

輸出

[<title>TutorialsPoint</title>]

返回的物件是一個列表,儘管在這種情況下,head 元素中只包含一個子標籤。

.children

.children 屬性也返回標籤中所有封閉元素的列表。下面,body 標籤中的所有元素都作為列表給出。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.body print (list(tag.children))

輸出

['\n', <p class="title"><b>Online Tutorials Library</b></p>, '\n', <p class="story">TutorialsPoint has an excellent collection of tutorials on: <a class="lang" href="https://tutorialspoint.tw/Python" id="link1">Python</a>, <a class="lang" href="https://tutorialspoint.tw/Java" id="link2">Java</a> and <a class="lang" href="https://tutorialspoint.tw/PHP" id="link3">PHP</a>; Enhance your Programming skills.</p>, '\n', <p class="tutorial">...</p>, '\n']

您可以使用 .children 生成器迭代標籤的子元素,而不是將它們作為列表獲取:

示例

tag = soup.body for child in tag.children: print (child)

輸出

<p class="title"><b>Online Tutorials Library</b></p> <p class="story">TutorialsPoint has an excellent collection of tutorials on: <a class="lang" href="https://tutorialspoint.tw/Python" id="link1">Python</a>, <a class="lang" href="https://tutorialspoint.tw/Java" id="link2">Java</a> and <a class="lang" href="https://tutorialspoint.tw/PHP" id="link3">PHP</a>; Enhance your Programming skills.</p> <p class="tutorial">...</p>

.descendents

.contents 和 .children 屬性僅考慮標籤的直接子元素。.descendants 屬性允許您遞迴地迭代標籤的所有子元素:它的直接子元素、其直接子元素的子元素,依此類推。

BeautifulSoup 物件位於所有標籤層次結構的頂部。因此,它的 .descendents 屬性包含 HTML 字串中的所有元素。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') print (soup.descendants)

.descendents 屬性返回一個生成器,可以使用 for 迴圈進行迭代。在這裡,我們列出 head 標籤的後代。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.head for element in tag.descendants: print (element)

輸出

<title>TutorialsPoint</title> TutorialsPoint

head 標籤包含一個 title 標籤,該標籤又包含一個 NavigableString 物件 TutorialsPoint。<head> 標籤只有一個子元素,但它有兩個後代:<title> 標籤和 <title> 標籤的子元素。但是 BeautifulSoup 物件只有一個直接子元素(<html> 標籤),但它有許多後代。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tags = list(soup.descendants) print (len(tags))

輸出

27

向上

就像您可以使用 children 和 descendents 屬性導航文件的下游一樣,BeautifulSoup 提供 .parent 和 .parent 屬性來導航標籤的上游

.parent

每個標籤和每個字串都有一個包含它的父標籤。您可以使用 parent 屬性訪問元素的父元素。在我們的示例中,<head> 標籤是 <title> 標籤的父元素。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.title print (tag.parent)

輸出

<head><title>TutorialsPoint</title></head>

由於 title 標籤包含一個字串(NavigableString),因此字串的父元素是 title 標籤本身。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.title string = tag.string print (string.parent)

輸出

<title>TutorialsPoint</title>

.parents

您可以使用 .parents 迭代元素的所有父元素。此示例使用 .parents 從文件深處隱藏的 <a> 標籤遍歷到文件的最頂部。在以下程式碼中,我們跟蹤示例 HTML 字串中第一個 <a> 標籤的父元素。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.a print (tag.string) for parent in tag.parents: print (parent.name)

輸出

Python p body html [document]

橫向

出現在相同縮排級別的 HTML 標籤稱為同級。考慮以下 HTML 程式碼段

<p>

<b>

Hello

</b>

<i>

Python

</i>

</p>

在外部 <p> 標籤中,我們在同一縮排級別上具有 <b> 和 <i> 標籤,因此它們被稱為同級。BeautifulSoup 使在同一級別的標籤之間導航成為可能。

.next_sibling 和 .previous_sibling

這些屬性分別返回同一級別上的下一個標籤和同一級別上的上一個標籤。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p><b>Hello</b><i>Python</i></p>", 'html.parser')

tag1 = soup.b

print ("next:",tag1.next_sibling)

tag2 = soup.i

print ("previous:",tag2.previous_sibling)

輸出

next: <i>Python</i> previous: <b>Hello</b>

由於 <b> 標籤左側沒有同級,<i> 標籤右側也沒有同級,因此在這兩種情況下它都返回 Nobe。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p><b>Hello</b><i>Python</i></p>", 'html.parser')

tag1 = soup.b

print ("next:",tag1.previous_sibling)

tag2 = soup.i

print ("previous:",tag2.next_sibling)

輸出

next: None previous: None

.next_siblings 和 .previous_siblings

如果標籤右側或左側有兩個或多個同級,則可以使用 .next_siblings 和 .previous_siblings 屬性分別導航它們。它們都返回生成器物件,以便可以使用 for 迴圈進行迭代。

讓我們為此目的使用以下 HTML 程式碼段:

<p>

<b>

Excellent

</b>

<i>

Python

</i>

<u>

Tutorial

</u>

</p>

使用以下程式碼遍歷下一個和上一個同級標籤。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p><b>Excellent</b><i>Python</i><u>Tutorial</u></p>", 'html.parser')

tag1 = soup.b

print ("next siblings:")

for tag in tag1.next_siblings:

print (tag)

print ("previous siblings:")

tag2 = soup.u

for tag in tag2.previous_siblings:

print (tag)

輸出

next siblings: <i>Python</i> <u>Tutorial</u> previous siblings: <i>Python</i> <b>Excellent</b>

來回

在 Beautiful Soup 中,next_element 屬性返回解析樹中的下一個字串或標籤。另一方面,previous_element 屬性返回解析樹中的上一個字串或標籤。有時,next_element 和 previous_element 屬性的返回值與 next_sibling 和 previous_sibling 屬性相似。

.next_element 和 .previous_element

示例

html = """

<html><head><title>TutorialsPoint</title></head>

<body>

<p class="title"><b>Online Tutorials Library</b></p>

<p class="story">TutorialsPoint has an excellent collection of tutorials on:

<a href="https://tutorialspoint.tw/Python" class="lang" id="link1">Python</a>,

<a href="https://tutorialspoint.tw/Java" class="lang" id="link2">Java</a> and

<a href="https://tutorialspoint.tw/PHP" class="lang" id="link3">PHP</a>;

Enhance your Programming skills.</p>

<p class="tutorial">...</p>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

tag = soup.find("a", id="link3")

print (tag.next_element)

tag = soup.find("a", id="link1")

print (tag.previous_element)

輸出

PHP TutorialsPoint has an excellent collection of tutorials on:

id = "link3" 的 <a> 標籤之後的 next_element 是字串 PHP。類似地,previous_element 返回 id = "link1" 的 <a> 標籤之前的字串。

.next_elements 和 .previous_elements

Tag 物件的這些屬性分別返回其後和其前所有標籤和字串的生成器。

Next elements 示例

tag = soup.find("a", id="link1")

for element in tag.next_elements:

print (element)

輸出

Python , <a class="lang" href="https://tutorialspoint.tw/Java" id="link2">Java</a> Java and <a class="lang" href="https://tutorialspoint.tw/PHP" id="link3">PHP</a> PHP ; Enhance your Programming skills. <p class="tutorial">...</p> ...

Previous elements 示例

tag = soup.find("body")

for element in tag.previous_elements:

print (element)

輸出

<html><head><title>TutorialsPoint</title></head>

Beautiful Soup - 修改樹結構

Beautiful Soup 庫的一個強大功能是能夠操縱已解析的 HTML 或 XML 文件並修改其內容。

Beautiful Soup 庫具有執行以下操作的不同函式:

將內容或新標籤新增到文件的現有標籤中

在現有標籤或字串之前或之後插入內容

清除現有標籤的內容

修改標籤元素的內容

新增內容

您可以使用 Tag 物件上的append() 方法新增到現有標籤的內容中。它的工作原理類似於 Python 列表物件的 append() 方法。

在以下示例中,HTML 指令碼有一個 <p> 標籤。使用 append(),附加了其他文字。

示例

from bs4 import BeautifulSoup

markup = '<p>Hello</p>'

soup = BeautifulSoup(markup, 'html.parser')

print (soup)

tag = soup.p

tag.append(" World")

print (soup)

輸出

<p>Hello</p> <p>Hello World</p>

使用 append() 方法,您可以在現有標籤的末尾新增一個新標籤。首先使用new_tag() 方法建立一個新的 Tag 物件,然後將其傳遞給 append() 方法。

示例

from bs4 import BeautifulSoup, Tag

markup = '<b>Hello</b>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.b

tag1 = soup.new_tag('i')

tag1.string = 'World'

tag.append(tag1)

print (soup.prettify())

輸出

<b>

Hello

<i>

World

</i>

</b>

如果必須將字串新增到文件中,則可以附加NavigableString 物件。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '<b>Hello</b>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.b

new_string = NavigableString(" World")

tag.append(new_string)

print (soup.prettify())

輸出

<b> Hello World </b>

從 Beautiful Soup 4.7 版開始,extend() 方法已新增到 Tag 類中。它將列表中的所有元素新增到標籤中。

示例

from bs4 import BeautifulSoup markup = '<b>Hello</b>' soup = BeautifulSoup(markup, 'html.parser') tag = soup.b vals = ['World.', 'Welcome to ', 'TutorialsPoint'] tag.extend(vals) print (soup.prettify())

輸出

<b> Hello World. Welcome to TutorialsPoint </b>

插入內容

您可以使用insert() 方法在 Tag 元素的子元素列表中的給定位置新增元素,而不是在末尾新增新元素。Beautiful Soup 中的 insert() 方法的行為類似於 Python 列表物件上的 insert()。

在以下示例中,一個新字串在位置 1 新增到 <b> 標籤中。生成的已解析文件顯示了結果。

示例

from bs4 import BeautifulSoup, NavigableString markup = '<b>Excellent </b><u>from TutorialsPoint</u>' soup = BeautifulSoup(markup, 'html.parser') tag = soup.b tag.insert(1, "Tutorial ") print (soup.prettify())

輸出

<b> Excellent Tutorial </b> <u> from TutorialsPoint </u>

Beautiful Soup 還有insert_before() 和insert_after() 方法。它們各自的目的是在給定的 Tag 物件之前或之後插入標籤或字串。以下程式碼顯示字串“Python 教程”已新增到 <b> 標籤之後。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '<b>Excellent </b><u>from TutorialsPoint</u>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.b

tag.insert_after("Python Tutorial")

print (soup.prettify())

輸出

<b> Excellent </b> Python Tutorial <u> from TutorialsPoint </u>

另一方面,下面使用 insert_before() 方法,在 <b> 標籤之前新增“這是一個”文字。

tag.insert_before("Here is an ")

print (soup.prettify())

輸出

Here is an <b> Excellent </b> Python Tutorial <u> from TutorialsPoint </u>

清除內容

Beautiful Soup 提供了多種從文件樹中刪除元素內容的方法。每種方法都有其獨特的特點。

clear() 方法是最直接的方法。它只是簡單地刪除指定 Tag 元素的內容。以下示例顯示了它的用法。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '<b>Excellent </b><u>from TutorialsPoint</u>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.find('u')

tag.clear()

print (soup.prettify())

輸出

<b> Excellent </b> <u> </u>

可以看出,clear() 方法刪除了內容,但保留了標籤。

對於以下示例,我們解析以下 HTML 文件並在所有標籤上呼叫 clear() 方法。

<html>

<body>

<p> The quick, brown fox jumps over a lazy dog.</p>

<p> DJs flock by when MTV ax quiz prog.</p>

<p> Junk MTV quiz graced by fox whelps.</p>

<p> Bawds jog, flick quartz, vex nymphs./p>

</body>

</html>

這是使用 clear() 方法的 Python 程式碼

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all()

for tag in tags:

tag.clear()

print (soup.prettify())

輸出

<html> </html>

extract() 方法從文件樹中刪除標籤或字串,並返回已刪除的物件。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all()

for tag in tags:

obj = tag.extract()

print ("Extracted:",obj)

print (soup)

輸出

Extracted: <html> <body> <p> The quick, brown fox jumps over a lazy dog.</p> <p> DJs flock by when MTV ax quiz prog.</p> <p> Junk MTV quiz graced by fox whelps.</p> <p> Bawds jog, flick quartz, vex nymphs.</p> </body> </html> Extracted: <body> <p> The quick, brown fox jumps over a lazy dog.</p> <p> DJs flock by when MTV ax quiz prog.</p> <p> Junk MTV quiz graced by fox whelps.</p> <p> Bawds jog, flick quartz, vex nymphs.</p> </body> Extracted: <p> The quick, brown fox jumps over a lazy dog.</p> Extracted: <p> DJs flock by when MTV ax quiz prog.</p> Extracted: <p> Junk MTV quiz graced by fox whelps.</p> Extracted: <p> Bawds jog, flick quartz, vex nymphs.</p>

您可以提取標籤或字串。以下示例顯示了正在提取的 antag。

示例

html = '''

<ol id="HR">

<li>Rani</li>

<li>Ankita</li>

</ol>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

obj=soup.find('ol')

obj.find_next().extract()

print (soup)

輸出

<ol id="HR"> <li>Ankita</li> </ol>

更改 extract() 語句以刪除第一個 <li> 元素的內部文字。

示例

obj.find_next().string.extract()

輸出

<ol id="HR"> <li>Ankita</li> </ol>

還有另一個方法 decompose(),它從樹中刪除標籤,然後完全銷燬它及其內容:

示例

html = '''

<ol id="HR">

<li>Rani</li>

<li>Ankita</li>

</ol>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

tag1=soup.find('ol')

tag2 = soup.find('li')

tag2.decompose()

print (soup)

print (tag2.decomposed)

輸出

<ol id="HR"> <li>Ankita</li> </ol>

decomposed 屬性返回 True 或 False——元素是否已被分解。

修改內容

我們將看看replace_with() 方法,它允許替換標籤的內容。

就像 Python 字串是不可變的,可導航字串也不能就地修改。但是,使用 replace_with() 將標籤的內部字串替換為另一個字串。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>",'html.parser')

tag = soup.h2

tag.string.replace_with("OnLine Tutorials Library")

print (tag.string)

輸出

OnLine Tutorials Library

這是另一個顯示 replace_with() 用法的示例。如果您將 BeautifulSoup 物件作為引數傳遞給某個函式(例如 replace_with()),則可以組合兩個已解析的文件。2524

示例

from bs4 import BeautifulSoup

obj1 = BeautifulSoup("<book><title>Python</title></book>", features="xml")

obj2 = BeautifulSoup("<b>Beautiful Soup parser</b>", "lxml")

obj2.find('b').replace_with(obj1)

print (obj2)

輸出

<html><body><book><title>Python</title></book></body></html>

wrap() 方法將元素包裝在您指定的標籤中。它返回新的包裝器。

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p>Hello Python</p>", 'html.parser')

tag = soup.p

newtag = soup.new_tag('b')

tag.string.wrap(newtag)

print (soup)

輸出

<p><b>Hello Python</b></p>

另一方面,unwrap() 方法用標籤內的任何內容替換標籤。它非常適合去除標記。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p>Hello <b>Python</b></p>", 'html.parser')

tag = soup.p

tag.b.unwrap()

print (soup)

輸出

<p>Hello Python</p>

Beautiful Soup - 解析文件的一部分

假設您想使用 Beautiful Soup 僅檢視文件的 <a> 標籤。通常,您會解析樹並使用 find_all() 方法,並將所需的標籤作為引數。

soup = BeautifulSoup(fp, "html.parser")

tags = soup.find_all('a')

但是,這也會非常耗時,並且會不必要地佔用更多記憶體。相反,您可以建立一個 SoupStrainer 類物件,並將其用作 BeautifulSoup 建構函式的 parse_only 引數的值。

SoupStrainer 告訴 BeautifulSoup 要提取哪些部分,並且解析樹僅包含這些元素。如果您將所需資訊縮小到 HTML 的特定部分,這將加快搜索結果的速度。

product = SoupStrainer('div',{'id': 'products_list'})

soup = BeautifulSoup(html,parse_only=product)

以上程式碼行將僅從產品網站解析標題,標題可能位於標籤欄位內。

類似地,就像上面一樣,我們可以使用其他 soupStrainer 物件從 HTML 標籤解析特定資訊。以下是一些示例 -

示例

from bs4 import BeautifulSoup, SoupStrainer

#Only "a" tags

only_a_tags = SoupStrainer("a")

#Will parse only the below mentioned "ids".

parse_only = SoupStrainer(id=["first", "third", "my_unique_id"])

soup = BeautifulSoup(my_document, "html.parser", parse_only=parse_only)

#parse only where string length is less than 10

def is_short_string(string):

return len(string) < 10

only_short_strings = SoupStrainer(string=is_short_string)

SoupStrainer 類接受與搜尋樹中的典型方法相同的引數:name、attrs、text 和 **kwargs。

請注意,如果您使用 html5lib 解析器,則此功能將不起作用,因為在這種情況下,無論如何都會解析整個文件。因此,您應該使用內建的 html.parser 或 lxml 解析器。

您還可以將 SoupStrainer 傳遞到“搜尋樹”中介紹的任何方法中。

from bs4 import SoupStrainer

a_tags = SoupStrainer("a")

soup = BeautifulSoup(html_doc, 'html.parser')

soup.find_all(a_tags)

Beautiful Soup - 查詢元素的所有子元素

HTML 指令碼中標籤的結構是分層的。元素巢狀在另一個元素內部。例如,頂級 <HTML> 標籤包含 <HEAD> 和 <BODY> 標籤,每個標籤都可能包含其他標籤。頂級元素稱為父元素。巢狀在父元素內部的元素是其子元素。藉助 Beautiful Soup,我們可以找到父元素的所有子元素。在本章中,我們將瞭解如何獲取 HTML 元素的子元素。

BeautifulSoup 類中有兩種方法可以獲取子元素。

- .children 屬性

- findChildren() 方法

本章中的示例使用以下 HTML 指令碼 (index.html)

<html> <head> <title>TutorialsPoint</title> </head> <body> <h2>Departmentwise Employees</h2> <ul id="dept"> <li>Accounts</li> <ul id='acc'> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul id="HR"> <li>Rani</li> <li>Ankita</li> </ul> </ul> </body> </html>

使用 .children 屬性

Tag 物件的 .children 屬性以遞迴方式返回所有子元素的生成器。

以下 Python 程式碼給出了頂級 <ul> 標籤的所有子元素的列表。我們首先獲取與 <ul> 標籤對應的 Tag 元素,然後讀取其 .children 屬性。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.ul

print (list(tag.children))

輸出

['\n', <li>Accounts</li>, '\n', <ul> <li>Anand</li> <li>Mahesh</li> </ul>, '\n', <li>HR</li>, '\n', <ul> <li>Rani</li> <li>Ankita</li> </ul>, '\n']

由於 .children 屬性返回一個列表迭代器,因此我們可以使用 for 迴圈來遍歷層次結構。

for child in tag.children: print (child)

輸出

<li>Accounts</li> <ul> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul> <li>Rani</li> <li>Ankita</li> </ul>

使用 findChildren() 方法

findChildren() 方法提供了一種更全面的替代方案。它返回任何頂級標籤下的所有子元素。

在 index.html 文件中,我們有兩個巢狀的無序列表。頂級 <ul> 元素的 id 為 "dept",兩個包含的列表的 id 分別為 "acc" 和 "HR"。

在以下示例中,我們首先例項化一個指向頂級 <ul> 元素的 Tag 物件,並提取其下的子元素列表。

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.find("ul", {"id": "dept"})

children = tag.findChildren()

for child in children:

print(child)

請注意,結果集以遞迴方式包含元素下的子元素。因此,在以下輸出中,您將找到整個內部列表,以及其中的各個元素。

<li>Accounts</li> <ul id="acc"> <li>Anand</li> <li>Mahesh</li> </ul> <li>Anand</li> <li>Mahesh</li> <li>HR</li> <ul id="HR"> <li>Rani</li> <li>Ankita</li> </ul> <li>Rani</li> <li>Ankita</li>

讓我們提取 id 為 'acc' 的內部 <ul> 元素下的子元素。程式碼如下 -

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.find("ul", {"id": "acc"})

children = tag.findChildren()

for child in children:

print(child)

執行上述程式時,您將獲得 id 為 acc 的 <ul> 下的 <li> 元素。

輸出

<li>Anand</li> <li>Mahesh</li>

因此,BeautifulSoup 使解析任何頂級 HTML 元素下的子元素變得非常容易。

Beautiful Soup - 使用 CSS 選擇器查詢元素

在 Beautiful Soup 庫中,select() 方法是抓取 HTML/XML 文件的重要工具。與 find() 和其他 find_*() 方法類似,select() 方法也有助於定位滿足給定條件的元素。但是,find*() 方法根據標籤名稱及其屬性搜尋 PageElements,而 select() 方法根據給定的 CSS 選擇器搜尋文件樹。

Beautiful Soup 還有 select_one() 方法。select() 和 select_one() 的區別在於,select() 返回屬於 PageElement 並以 CSS 選擇器為特徵的所有元素的結果集;而 select_one() 返回滿足基於 CSS 選擇器選擇標準的元素的第一個出現。

在 Beautiful Soup 4.7 版本之前,select() 方法只能支援常見的 CSS 選擇器。隨著 4.7 版本的釋出,Beautiful Soup 集成了 Soup Sieve CSS 選擇器庫。因此,現在可以使用更多的選擇器。在 4.12 版本中,除了現有的便捷方法 select() 和 select_one() 之外,還添加了一個 .css 屬性。select() 方法的引數如下 -

select(selector, limit, **kwargs)

selector - 包含 CSS 選擇器的字串。

limit - 找到此數量的結果後,停止查詢。

kwargs - 要傳遞的關鍵字引數。

如果將 limit 引數設定為 1,則它等效於 select_one() 方法。select() 方法返回 Tag 物件的結果集,而 select_one() 方法返回單個 Tag 物件。

Soup Sieve 庫

Soup Sieve 是一個 CSS 選擇器庫。它已與 Beautiful Soup 4 整合,因此與 Beautiful Soup 包一起安裝。它提供了使用現代 CSS 選擇器選擇、匹配和過濾文件樹標籤的功能。Soup Sieve 目前實現了從 CSS 級別 1 規範到 CSS 級別 4 的大多數 CSS 選擇器,除了某些尚未實現的選擇器。

Soup Sieve 庫有不同型別的 CSS 選擇器。基本 CSS 選擇器為 -

型別選擇器

透過節點名稱匹配元素。例如 -

tags = soup.select('div')

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tags = soup.select('div')

print (tags)

輸出

[<div id="Languages"> <p>Java</p> <p>Python</p> <p>C++</p> </div>]

通用選擇器 (*)

它匹配任何型別的元素。例如 -

tags = soup.select('*')

ID 選擇器

它根據元素的 id 屬性匹配元素。符號 # 表示 ID 選擇器。例如 -

tags = soup.select("#nm")

示例

from bs4 import BeautifulSoup

html = '''

<form>

<input type = 'text' id = 'nm' name = 'name'>

<input type = 'text' id = 'age' name = 'age'>

<input type = 'text' id = 'marks' name = 'marks'>

</form>

'''

soup = BeautifulSoup(html, 'html.parser')

obj = soup.select("#nm")

print (obj)

輸出

[<input id="nm" name="name" type="text"/>]

類選擇器

它根據 class 屬性中包含的值匹配元素。字首為類名稱的 . 符號是 CSS 類選擇器。例如 -

tags = soup.select(".submenu")

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tags = soup.select('div')

print (tags)

輸出

[<div id="Languages"> <p>Java</p> <p>Python</p> <p>C++</p> </div>]

屬性選擇器

屬性選擇器根據元素的屬性匹配元素。

soup.select('[attr]')

示例

from bs4 import BeautifulSoup

html = '''

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

<a class="prog" href="https://tutorialspoint.tw/java/java_overview.htm" id="link1">Java</a>

<a class="prog" href="https://tutorialspoint.tw/cprogramming/index.htm" id="link2">C</a>

'''

soup = BeautifulSoup(html, 'html5lib')

print(soup.select('[href]'))

輸出

[<a class="prog" href="https://tutorialspoint.tw/java/java_overview.htm" id="link1">Java</a>, <a class="prog" href="https://tutorialspoint.tw/cprogramming/index.htm" id="link2">C</a>]

偽類

CSS 規範定義了許多偽 CSS 類。偽類是新增到選擇器中的關鍵字,用於定義所選元素的特殊狀態。它為現有元素新增效果。例如,:link 選擇尚未訪問的連結(每個具有 href 屬性的 <a> 和 <area> 元素)。

偽類選擇器 nth-of-type 和 nth-child 非常廣泛使用。

:nth-of-type()

選擇器 :nth-of-type() 根據元素在兄弟元素組中的位置匹配給定型別的元素。關鍵字 even 和 odd 分別將從兄弟元素的子組中選擇元素。

在以下示例中,選擇了 <p> 型別的第二個元素。

示例

from bs4 import BeautifulSoup

html = '''

<p id="0"></p>

<p id="1"></p>

<span id="2"></span>

<span id="3"></span>

'''

soup = BeautifulSoup(html, 'html5lib')

print(soup.select('p:nth-of-type(2)'))

輸出

[<p id="1"></p>]

:nth-child()

此選擇器根據元素在一組兄弟元素中的位置匹配元素。關鍵字 even 和 odd 分別將選擇在一組兄弟元素中位置為偶數或奇數的元素。

用法

:nth-child(even) :nth-child(odd) :nth-child(2)

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.div

child = tag.select_one(':nth-child(2)')

print (child)

輸出

<p>Python</p>

Beautiful Soup - 查詢所有註釋

在計算機程式碼中插入註釋被認為是一種良好的程式設計實踐。註釋有助於理解程式的邏輯。它們也用作文件。您可以在 HTML 和 XML 指令碼中添加註釋,就像在用 C、Java、Python 等編寫的程式中一樣。BeautifulSoup API 可以幫助識別 HTML 文件中的所有註釋。

在 HTML 和 XML 中,註釋文字寫在 <!-- 和 --> 標籤之間。

<!-- Comment Text -->

BeutifulSoup 包(其內部名稱為 bs4)將 Comment 定義為一個重要的物件。Comment 物件是一種特殊的 NavigableString 物件。因此,在 <!-- 和 --> 之間找到的任何 Tag 的 string 屬性都被識別為 Comment。

示例

from bs4 import BeautifulSoup markup = "<b><!--This is a comment text in HTML--></b>" soup = BeautifulSoup(markup, 'html.parser') comment = soup.b.string print (comment, type(comment))

輸出

This is a comment text in HTML <class 'bs4.element.Comment'>

要搜尋 HTML 文件中註釋的所有出現,我們將使用 find_all() 方法。如果沒有引數,find_all() 將返回解析後的 HTML 文件中的所有元素。您可以將關鍵字引數 'string' 傳遞給 find_all() 方法。我們將為其分配函式 iscomment() 的返回值。

comments = soup.find_all(string=iscomment)

iscomment() 函式使用 isinstance() 函式驗證標籤中的文字是否為註釋物件。

def iscomment(elem): return isinstance(elem, Comment)

comments 變數將儲存給定 HTML 文件中的所有註釋文字出現。我們將在示例程式碼中使用以下 index.html 檔案 -

<html>

<head>

<!-- Title of document -->

<title>TutorialsPoint</title>

</head>

<body>

<!-- Page heading -->

<h2>Departmentwise Employees</h2>

<!-- top level list-->

<ul id="dept">

<li>Accounts</li>

<ul id='acc'>

<!-- first inner list -->

<li>Anand</li>

<li>Mahesh</li>

</ul>

<li>HR</li>

<ul id="HR">

<!-- second inner list -->

<li>Rani</li>

<li>Ankita</li>

</ul>

</ul>

</body>

</html>

以下 Python 程式抓取上述 HTML 文件,並查詢其中的所有註釋。

示例

from bs4 import BeautifulSoup, Comment

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

def iscomment(elem):

return isinstance(elem, Comment)

comments = soup.find_all(string=iscomment)

print (comments)

輸出

[' Title of document ', ' Page heading ', ' top level list', ' first inner list ', ' second inner list ']

以上輸出顯示了所有註釋的列表。我們還可以對註釋集合使用 for 迴圈。

示例

i=0 for comment in comments: i+=1 print (i,".",comment)

輸出

1 . Title of document 2 . Page heading 3 . top level list 4 . first inner list 5 . second inner list

在本章中,我們學習瞭如何提取 HTML 文件中的所有註釋字串。

Beautiful Soup - 從 HTML 中抓取列表

網頁通常以有序或無序列表的形式包含重要資料。使用 Beautiful Soup,我們可以輕鬆地提取 HTML 列表元素,將資料轉換為 Python 物件,並將其儲存在資料庫中以供進一步分析。在本章中,我們將使用 find() 和 select() 方法從 HTML 文件中抓取列表資料。

搜尋解析樹最簡單的方法是按其名稱搜尋標籤。soup.<tag> 獲取給定標籤的內容。

HTML 提供 <ol> 和 <ul> 標籤來組成有序和無序列表。與任何其他標籤一樣,我們可以獲取這些標籤的內容。

我們將使用以下 HTML 文件 -

<html>

<body>

<h2>Departmentwise Employees</h2>

<ul id="dept">

<li>Accounts</li>

<ul id='acc'>

<li>Anand</li>

<li>Mahesh</li>

</ul>

<li>HR</li>

<ol id="HR">

<li>Rani</li>

<li>Ankita</li>

</ol>

</ul>

</body>

</html>

按標籤抓取列表

在上面的 HTML 文件中,我們有一個頂級 <ul> 列表,其中包含另一個 <ul> 標籤和另一個 <ol> 標籤。我們首先在 soup 物件中解析文件,並在 soup.ul Tag 物件中檢索第一個 <ul> 的內容。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.ul

print (lst)

輸出

<ul id="dept"> <li>Accounts</li> <ul id="acc"> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ol id="HR"> <li>Rani</li> <li>Ankita</li> </ol> </ul>

更改 lst 的值以指向 <ol> 元素以獲取內部列表。

lst=soup.ol

輸出

<ol id="HR"> <li>Rani</li> <li>Ankita</li> </ol>

使用 select() 方法

select() 方法主要用於使用 CSS 選擇器獲取資料。但是,您也可以向其傳遞標籤。在這裡,我們可以將 ol 標籤傳遞給 select() 方法。select_one() 方法也可用。它獲取給定標籤的第一個出現。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.select("ol")

print (lst)

輸出

[<ol id="HR"> <li>Rani</li> <li>Ankita</li> </ol>]

使用 find_all() 方法

find() 和 fin_all() 方法更全面。您可以將各種型別的過濾器(如標籤、屬性或字串等)傳遞給這些方法。在這種情況下,我們想要獲取列表標籤的內容。

在以下程式碼中,find_all() 方法返回 <ul> 標籤中所有元素的列表。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.find_all("ul")

print (lst)

我們可以透過包含 attrs 引數來細化搜尋過濾器。在我們的 HTML 文件中,<ul> 和 <ol> 標籤,我們已經指定了它們各自的 id 屬性。因此,讓我們獲取具有 id="acc" 的 <ul> 元素的內容。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.find_all("ul", {"id":"acc"})

print (lst)

輸出

[<ul id="acc"> <li>Anand</li> <li>Mahesh</li> </ul>]

這是一個其他示例。我們收集所有帶有 <li> 標籤的元素,其內部文字以 'A' 開頭。find_all() 方法採用關鍵字引數 string。如果 startingwith() 函式返回 True,則它將獲取文字的值。

示例

from bs4 import BeautifulSoup

def startingwith(ch):

return ch.startswith('A')

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.find_all('li',string=startingwith)

print (lst)

輸出

[<li>Accounts</li>, <li>Anand</li>, <li>Ankita</li>]

Beautiful Soup - 從 HTML 中抓取段落

HTML 文件中經常出現的標籤之一是 <p> 標籤,它標記段落文字。使用 Beautiful Soup,您可以輕鬆地從解析的文件樹中提取段落。在本章中,我們將討論以下使用 BeautifulSoup 庫抓取段落的方法。

使用 <p> 標籤抓取 HTML 段落

使用 find_all() 方法抓取 HTML 段落

使用 select() 方法抓取 HTML 段落

我們將使用以下 HTML 文件進行這些練習 -

<html>

<head>

<title>BeautifulSoup - Scraping Paragraph</title>

</head>

<body>

<p id='para1'>The quick, brown fox jumps over a lazy dog.</p>

<h2>Hello</h2>

<p>DJs flock by when MTV ax quiz prog.</p>

<p>Junk MTV quiz graced by fox whelps.</p>

<p>Bawds jog, flick quartz, vex nymphs.</p>

</body>

</html>

按 <p> 標籤抓取

搜尋解析樹最簡單的方法是按其名稱搜尋標籤。因此,表示式 soup.p 指向抓取的文件中的第一個 <p> 標籤。

para = soup.p

要獲取所有後續的<p>標籤,可以執行一個迴圈,直到soup物件中所有的<p>標籤都被遍歷完。以下程式顯示了所有段落標籤的美化輸出。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

para = soup.p

print (para.prettify())

while True:

p = para.find_next('p')

if p is None:

break

print (p.prettify())

para=p

輸出

<p> The quick, brown fox jumps over a lazy dog. </p> <p> DJs flock by when MTV ax quiz prog. </p> <p> Junk MTV quiz graced by fox whelps. </p> <p> Bawds jog, flick quartz, vex nymphs. </p>

使用 find_all() 方法

find_all()方法更全面。您可以將各種型別的過濾器(例如標籤、屬性或字串等)傳遞給此方法。在本例中,我們想要獲取<p>標籤的內容。

在以下程式碼中,find_all()方法返回<p>標籤中所有元素的列表。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

paras = soup.find_all('p')

for para in paras:

print (para.prettify())

輸出

<p> The quick, brown fox jumps over a lazy dog. </p> <p> DJs flock by when MTV ax quiz prog. </p> <p> Junk MTV quiz graced by fox whelps. </p> <p> Bawds jog, flick quartz, vex nymphs. </p>

我們可以使用另一種方法來查詢所有<p>標籤。首先,使用find_all()獲取所有標籤的列表,並檢查每個標籤的Tag.name是否等於'p'。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all()

paras = [tag.contents for tag in tags if tag.name=='p']

print (paras)

find_all()方法還有一個attrs引數。當您想要提取具有特定屬性的<p>標籤時,它非常有用。例如,在給定的文件中,第一個<p>元素具有id='para1'。要獲取它,我們需要修改標籤物件如下所示:

paras = soup.find_all('p', attrs={'id':'para1'})

使用 select() 方法

select()方法主要用於使用CSS選擇器獲取資料。但是,您也可以將標籤傳遞給它。在這裡,我們可以將<p>標籤傳遞給select()方法。select_one()方法也可用。它獲取<p>標籤的第一次出現。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

paras = soup.select('p')

print (paras)

輸出

[ <p>The quick, brown fox jumps over a lazy dog.</p>, <p>DJs flock by when MTV ax quiz prog.</p>, <p>Junk MTV quiz graced by fox whelps.</p>, <p>Bawds jog, flick quartz, vex nymphs.</p> ]

要過濾掉具有特定id的<p>標籤,請使用如下所示的for迴圈:

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.select('p')

for tag in tags:

if tag.has_attr('id') and tag['id']=='para1':

print (tag.contents)

輸出

['The quick, brown fox jumps over a lazy dog.']

BeautifulSoup - 從 HTML 中抓取連結

在從具有網站的資源中抓取和分析內容時,您通常需要提取某個頁面包含的所有連結。在本章中,我們將瞭解如何從HTML文件中提取連結。

HTML使用錨標籤<a>來插入超連結。錨標籤的href屬性允許您建立連結。它使用以下語法:

<a href=="web page URL">hypertext</a>

使用find_all()方法,我們可以收集文件中的所有錨標籤,然後列印每個錨標籤的href屬性的值。

在下面的示例中,我們提取了Google主頁上找到的所有連結。我們使用requests庫來收集https://google.com的HTML內容,將其解析為soup物件,然後收集所有<a>標籤。最後,我們列印href屬性。

示例

from bs4 import BeautifulSoup

import requests

url = "https://www.google.com/"

req = requests.get(url)

soup = BeautifulSoup(req.content, "html.parser")

tags = soup.find_all('a')

links = [tag['href'] for tag in tags]

for link in links:

print (link)

以下是執行上述程式時部分輸出:

輸出

https://www.google.co.in/imghp?hl=en&tab=wi https://maps.google.co.in/maps?hl=en&tab=wl https://play.google.com/?hl=en&tab=w8 https://www.youtube.com/?tab=w1 https://news.google.com/?tab=wn https://mail.google.com/mail/?tab=wm https://drive.google.com/?tab=wo https://www.google.co.in/intl/en/about/products?tab=wh http://www.google.co.in/history/optout?hl=en /preferences?hl=en https://#/ServiceLogin?hl=en&passive=true&continue=https://www.google.com/&ec=GAZAAQ /advanced_search?hl=en-IN&authuser=0 https://www.google.com/url?q=https://io.google/2023/%3Futm_source%3Dgoogle-hpp%26utm_medium%3Dembedded_marketing%26utm_campaign%3Dhpp_watch_live%26utm_content%3D&source=hpp&id=19035434&ct=3&usg=AOvVaw0qzqTkP5AEv87NM-MUDd_u&sa=X&ved=0ahUKEwiPzpjku-z-AhU1qJUCHVmqDJoQ8IcBCAU

但是,HTML文件可能具有不同協議方案的超連結,例如用於連結到電子郵件ID的mailto:協議,用於連結到電話號碼的tel:方案,或用於連結到具有file:// URL方案的本地檔案的連結。在這種情況下,如果我們有興趣提取具有https://方案的連結,我們可以透過以下示例來實現。我們有一個包含不同型別超連結的HTML文件,其中僅提取了具有https://字首的超連結。

html = '''

<p><a href="https://tutorialspoint.tw">Web page link </a></p>

<p><a href="https://www.example.com">Web page link </a></p>

<p><a href="mailto:nowhere@mozilla.org">Email link</a></p>

<p><a href="tel:+4733378901">Telephone link</a></p>

'''

from bs4 import BeautifulSoup

import requests

soup = BeautifulSoup(html, "html.parser")

tags = soup.find_all('a')

links = [tag['href'] for tag in tags]

for link in links:

if link.startswith("https"):

print (link)

輸出

https://tutorialspoint.tw https://www.example.com

Beautiful Soup - 獲取所有 HTML 標籤

HTML中的標籤就像Python或Java等傳統程式語言中的關鍵字。標籤具有預定義的行為,瀏覽器根據該行為呈現其內容。使用Beautiful Soup,可以收集給定HTML文件中的所有標籤。

獲取標籤列表的最簡單方法是將網頁解析為soup物件,然後呼叫不帶任何引數的find_all()方法。它返回一個列表生成器,為我們提供所有標籤的列表。

讓我們提取Google主頁中所有標籤的列表。

示例

from bs4 import BeautifulSoup import requests url = "https://www.google.com/" req = requests.get(url) soup = BeautifulSoup(req.content, "html.parser") tags = soup.find_all() print ([tag.name for tag in tags])

輸出

['html', 'head', 'meta', 'meta', 'title', 'script', 'style', 'style', 'script', 'body', 'script', 'div', 'div', 'nobr', 'b', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'u', 'div', 'nobr', 'span', 'span', 'span', 'a', 'a', 'a', 'div', 'div', 'center', 'br', 'div', 'img', 'br', 'br', 'form', 'table', 'tr', 'td', 'td', 'input', 'input', 'input', 'input', 'input', 'div', 'input', 'br', 'span', 'span', 'input', 'span', 'span', 'input', 'script', 'input', 'td', 'a', 'input', 'script', 'div', 'div', 'br', 'div', 'style', 'div', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'span', 'div', 'div', 'a', 'a', 'a', 'a', 'p', 'a', 'a', 'script', 'script', 'script']

當然,您可能會得到這樣一個列表,其中某個特定標籤可能會出現多次。要獲得唯一的標籤列表(避免重複),請從標籤物件列表中構造一個集合。

將上面程式碼中的print語句更改為

示例

print ({tag.name for tag in tags})

輸出

{'body', 'head', 'p', 'a', 'meta', 'tr', 'nobr', 'script', 'br', 'img', 'b', 'form', 'center', 'span', 'div', 'input', 'u', 'title', 'style', 'td', 'table', 'html'}

要獲取與某些文字關聯的標籤,請檢查字串屬性,如果它不是None,則列印。

tags = soup.find_all()

for tag in tags:

if tag.string is not None:

print (tag.name, tag.string)

可能有一些不帶文字但帶有一個或多個屬性的單例標籤,例如<img>標籤。以下迴圈構建了此類標籤的列表。

在以下程式碼中,HTML字串不是完整的HTML文件,因為它沒有給出<html>和<body>標籤。但是,html5lib和lxml解析器在解析文件樹時會自行新增這些標籤。因此,當我們提取標籤列表時,也會看到額外的標籤。

示例

html = '''

<h1 style="color:blue;text-align:center;">This is a heading</h1>

<p style="color:red;">This is a paragraph.</p>

<p>This is another paragraph</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html5lib")

tags = soup.find_all()

print ({tag.name for tag in tags} )

輸出

{'head', 'html', 'p', 'h1', 'body'}

Beautiful Soup - 獲取標籤內的文字

HTML中有兩種型別的標籤。許多標籤成對出現,分別是開始標籤和結束標籤。頂級<html>標籤具有相應的結束</html>標籤,這是一個主要示例。其他的有<body>和</body>、<p>和</p>、<h1>和</h1>等等。其他標籤是自閉合標籤,例如<img>和<a>。自閉合標籤沒有文字,就像大多數帶有開始和結束符號的標籤(例如<b>Hello</b>)一樣。在本章中,我們將瞭解如何藉助Beautiful Soup庫獲取此類標籤內部的文字部分。

Beautiful Soup中有多種方法/屬性可用於獲取與標籤物件關聯的文字。

| 序號 | 方法及描述 |

|---|---|

| 1 | text屬性 獲取PageElement的所有子字串,如果指定則使用分隔符連線。 |

| 2 | string屬性 方便地從子元素獲取字串。 |

| 3 | strings屬性 從當前PageElement下的所有子物件生成字串部分。 |

| 4 | stripped_strings屬性 與strings屬性相同,但刪除了換行符和空格。 |

| 5 | get_text()方法 返回此PageElement的所有子字串,如果指定則使用分隔符連線。 |

考慮以下HTML文件:

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

如果我們檢索解析的文件樹中每個標籤的stripped_string屬性,我們會發現兩個div標籤和p標籤有兩個NavigableString物件,分別是Hello和World。<b>標籤包含world字串,而<img>沒有文字部分。

以下示例從給定HTML文件中的每個標籤中獲取文字:

示例

html = """

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

for tag in soup.find_all():

print ("Tag: {} attributes: {} ".format(tag.name, tag.attrs))

for txt in tag.stripped_strings:

print (txt)

print()

輸出

Tag: div attributes: {'id': 'outer'}

Hello

World

Tag: div attributes: {'id': 'inner'}

Hello

World

Tag: p attributes: {}

Hello

World

Tag: b attributes: {}

World

Tag: img attributes: {'src': 'logo.jpg'}

Beautiful Soup - 查詢所有標題

在本章中,我們將探討如何使用BeautifulSoup在HTML文件中查詢所有標題元素。HTML定義了從H1到H6的六種標題樣式,每種標題樣式的字型大小都逐漸減小。不同的頁面部分使用合適的標籤,例如主標題、章節標題、主題等。讓我們以兩種不同的方式使用find_all()方法來提取HTML文件中的所有標題元素。

我們將在本章的程式碼示例中使用以下HTML指令碼(儲存為index.html):

<html>

<head>

<title>BeautifulSoup - Scraping Headings</title>

</head>

<body>

<h2>Scraping Headings</h2>

<b>The quick, brown fox jumps over a lazy dog.</b>

<h3>Paragraph Heading</h3>

<p>DJs flock by when MTV ax quiz prog.</p>

<h3>List heading</h3>

<ul>

<li>Junk MTV quiz graced by fox whelps.</li>

<li>Bawds jog, flick quartz, vex nymphs.</li>

</ul>

</body>

</html>

示例1

在這種方法中,我們收集解析樹中的所有標籤,並檢查每個標籤的名稱是否在所有標題標籤的列表中找到。

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

headings = ['h1','h2','h3', 'h4', 'h5', 'h6']

tags = soup.find_all()

heads = [(tag.name, tag.contents[0]) for tag in tags if tag.name in headings]

print (heads)

這裡,headings是所有標題樣式h1到h6的列表。如果標籤的名稱是其中的任何一個,則該標籤及其內容將被收集到名為heads的列表中。

輸出

[('h2', 'Scraping Headings'), ('h3', 'Paragraph Heading'), ('h3', 'List heading')]

示例2

您可以將正則表示式傳遞給find_all()方法。請檢視以下正則表示式。

re.compile('^h[1-6]$')

此正則表示式查詢以h開頭,h後面有一個數字,然後在數字後結束的所有標籤。讓我們在下面的程式碼中將其用作find_all()方法的引數:

from bs4 import BeautifulSoup

import re

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all(re.compile('^h[1-6]$'))

print (tags)

輸出

[<h2>Scraping Headings</h2>, <h3>Paragraph Heading</h3>, <h3>List heading</h3>]

Beautiful Soup - 提取標題標籤

<title>標籤用於為頁面提供出現在瀏覽器標題欄中的文字標題。它不是網頁主要內容的一部分。title標籤始終位於<head>標籤內。

我們可以透過Beautiful Soup提取title標籤的內容。我們解析HTML樹並獲取title標籤物件。

示例

html = '''

<html>

<head>

<Title>Python Libraries</title>

</head>

<body>

<p Hello World</p>

</body>

</html>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html5lib")

title = soup.title

print (title)

輸出

<title>Python Libraries</title>

在HTML中,我們可以將title屬性與所有標籤一起使用。title屬性提供有關元素的附加資訊。當滑鼠懸停在元素上時,該資訊作為工具提示文字顯示。

我們可以使用以下程式碼片段提取每個標籤的title屬性的文字:

示例

html = '''

<html>

<body>

<p title='parsing HTML and XML'>Beautiful Soup</p>

<p title='HTTP library'>requests</p>

<p title='URL handling'>urllib</p>

</body>

</html>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html5lib")

tags = soup.find_all()

for tag in tags:

if tag.has_attr('title'):

print (tag.attrs['title'])

輸出

parsing HTML and XML HTTP library URL handling

Beautiful Soup - 提取電子郵件 ID

從網頁中提取電子郵件地址是BeautifulSoup等網路抓取庫的重要應用。在任何網頁中,電子郵件ID通常出現在錨<a>標籤的href屬性中。電子郵件ID使用mailto URL方案編寫。很多時候,電子郵件地址可能作為普通文字出現在頁面內容中(沒有任何超連結)。在本章中,我們將使用BeautifulSoup庫透過簡單的技術從HTML頁面獲取電子郵件ID。

href屬性中電子郵件ID的典型用法如下所示:

<a href = "mailto:xyz@abc.com">test link</a>

在第一個示例中,我們將考慮以下HTML文件,以從中提取超連結中的電子郵件ID:

<html>

<head>

<title>BeautifulSoup - Scraping Email IDs</title>

</head>

<body>

<h2>Contact Us</h2>

<ul>

<li><a href = "mailto:sales@company.com">Sales Enquiries</a></li>

<li><a href = "mailto:careers@company.com">Careers</a></li>

<li><a href = "mailto:partner@company.com">Partner with us</a></li>

</ul>

</body>

</html>

以下是查詢電子郵件ID的Python程式碼。我們收集文件中的所有<a>標籤,並檢查該標籤是否具有href屬性。如果是,則其值從第6個字元開始的部分就是電子郵件ID。

from bs4 import BeautifulSoup

import re

fp = open("contact.html")

soup = BeautifulSoup(fp, "html.parser")

tags = soup.find_all("a")

for tag in tags:

if tag.has_attr("href") and tag['href'][:7]=='mailto:':

print (tag['href'][7:])

對於給定的HTML文件,電子郵件ID將按如下方式提取:

sales@company.com careers@company.com partner@company.com

在第二個示例中,我們假設電子郵件ID出現在文字中的任何位置。要提取它們,我們使用正則表示式搜尋機制。正則表示式是一種複雜的字元模式。Python的re模組有助於處理正則表示式模式。以下正則表示式模式用於搜尋電子郵件地址:

pat = r'[\w.+-]+@[\w-]+\.[\w.-]+'

對於此練習,我們將使用以下HTML文件,其中<li>標籤包含電子郵件ID。

<html>

<head>

<title>BeautifulSoup - Scraping Email IDs</title>

</head>

<body>

<h2>Contact Us</h2>

<ul>

<li>Sales Enquiries: sales@company.com</a></li>

<li>Careers: careers@company.com</a></li>

<li>Partner with us: partner@company.com</a></li>

</ul>

</body>

</html>

使用電子郵件正則表示式,我們將查詢模式在每個<li>標籤字串中的出現情況。以下是Python程式碼:

示例

from bs4 import BeautifulSoup

import re

def isemail(s):

pat = r'[\w.+-]+@[\w-]+\.[\w.-]+'

grp=re.findall(pat,s)

return (grp)

fp = open("contact.html")

soup = BeautifulSoup(fp, "html.parser")

tags = soup.find_all('li')

for tag in tags:

emails = isemail(tag.string)

if emails:

print (emails)

輸出

['sales@company.com'] ['careers@company.com'] ['partner@company.com']

使用上面描述的簡單技術,我們可以使用BeautifulSoup從網頁中提取電子郵件ID。

Beautiful Soup - 抓取巢狀標籤

HTML文件中標籤或元素的排列具有層次結構的性質。標籤可以巢狀到多個級別。例如,<head>和<body>標籤巢狀在<html>標籤內。類似地,一個或多個<li>標籤可能位於<ul>標籤內。在本章中,我們將瞭解如何抓取具有一個或多個巢狀在其中的子標籤的標籤。

讓我們考慮以下HTML文件:

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

在這種情況下,兩個<div>標籤和一個<p>標籤有一個或多個巢狀在其中的子元素。而<img>和<b>標籤沒有任何子標籤。

findChildren()方法返回標籤下所有子元素的ResultSet。因此,如果標籤沒有任何子元素,則ResultSet將是一個空列表,例如[]。

以此為線索,以下程式碼查詢文件樹中每個標籤下的標籤並顯示列表。

示例

html = """

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

for tag in soup.find_all():

print ("Tag: {} attributes: {}".format(tag.name, tag.attrs))

print ("Child tags: ", tag.findChildren())

print()

輸出

Tag: div attributes: {'id': 'outer'}

Child tags: [<div id="inner">

<p>Hello<b>World</b></p>

<img src="logo.jpg"/>

</div>, <p>Hello<b>World</b></p>, <b>World</b>, <img src="logo.jpg"/>]

Tag: div attributes: {'id': 'inner'}

Child tags: [<p>Hello<b>World</b></p>, <b>World</b>, <img src="logo.jpg"/>]

Tag: p attributes: {}

Child tags: [<b>World</b>]

Tag: b attributes: {}

Child tags: []

Tag: img attributes: {'src': 'logo.jpg'}

Child tags: []

Beautiful Soup - 解析表格

除了文字內容之外,HTML文件還可以以HTML表格的形式包含結構化資料。使用Beautiful Soup,我們可以將表格資料提取到Python物件(例如列表或字典)中,如果需要,可以將其儲存在資料庫或電子表格中,並執行處理。在本章中,我們將使用Beautiful Soup解析HTML表格。

儘管Beautiful Soup沒有用於提取表格資料的任何特殊函式或方法,但我們可以透過簡單的抓取技術來實現它。就像任何表格(例如SQL或電子表格中的表格)一樣,HTML表格由行和列組成。

HTML使用<table>標籤來構建表格結構。有一個或多個巢狀的<tr>標籤,每個標籤代表一行。每一行都包含<td>標籤,用於儲存該行每個單元格中的資料。第一行通常用於列標題,標題放在<th>標籤而不是<td>標籤中。

以下HTML指令碼在瀏覽器視窗中呈現一個簡單的表格:

<html>

<body>

<h2>Beautiful Soup - Parse Table</h2>

<table border="1">

<tr>

<th>Name</th>

<th>Age</th>

<th>Marks</th>

</tr>

<tr class='data'>

<td>Ravi</td>

<td>23</td>

<td>67</td>

</tr>

<tr class='data'>

<td>Anil</td>

<td>27</td>

<td>84</td>

</tr>

</table>

</body>

</html>

請注意,資料行的外觀使用CSS類data進行了自定義,以便將其與標題行區分開來。

現在我們將瞭解如何解析表格資料。首先,我們在 BeautifulSoup 物件中獲取文件樹。然後將所有列標題收集到一個列表中。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup(markup, "html.parser")

tbltag = soup.find('table')

headers = []

headings = tbltag.find_all('th')

for h in headings: headers.append(h.string)

然後獲取在標題行之後具有 class='data' 屬性的資料行標籤。形成一個字典物件,其中列標題作為鍵,每個單元格中的對應值作為值,並將該字典物件追加到一個字典物件列表中。

rows = tbltag.find_all_next('tr', {'class':'data'})

trows=[]

for i in rows:

row = {}

data = i.find_all('td')

n=0

for j in data:

row[headers[n]] = j.string

n+=1

trows.append(row)

一個字典物件列表被收集到 trows 中。然後可以將其用於不同的目的,例如儲存在 SQL 表中、儲存為 JSON 或 pandas DataFrame 物件。

完整的程式碼如下所示:

markup = """

<html>

<body>

<p>Beautiful Soup - Parse Table</p>

<table>

<tr>

<th>Name</th>

<th>Age</th>

<th>Marks</th>

</tr>

<tr class='data'>

<td>Ravi</td>

<td>23</td>

<td>67</td>

</tr>

<tr class='data'>

<td>Anil</td>

<td>27</td>

<td>84</td>

</tr>

</table>

</body>

</html>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(markup, "html.parser")

tbltag = soup.find('table')

headers = []

headings = tbltag.find_all('th')

for h in headings: headers.append(h.string)

print (headers)

rows = tbltag.find_all_next('tr', {'class':'data'})

trows=[]

for i in rows:

row = {}

data = i.find_all('td')

n=0

for j in data:

row[headers[n]] = j.string

n+=1

trows.append(row)

print (trows)

輸出

[{'Name': 'Ravi', 'Age': '23', 'Marks': '67'}, {'Name': 'Anil', 'Age': '27', 'Marks': '84'}]

Beautiful Soup - 選擇第 n 個子元素

HTML 的特點是標籤的層次順序。例如,<html> 標籤包含 <body> 標籤,在 <body> 標籤內部可能存在 <div> 標籤,並且 <div> 標籤可能進一步巢狀 <ul> 和 <li> 元素。findChildren() 方法和 .children 屬性都返回一個 ResultSet(列表),其中包含元素下所有直接子標籤。透過遍歷列表,可以獲取位於所需位置(第 n 個子元素)的子元素。

下面的程式碼使用 HTML 文件中 <div> 標籤的 children 屬性。由於 children 屬性的返回型別是列表迭代器,因此我們將從中檢索一個 Python 列表。我們還需要從迭代器中刪除空格和換行符。完成後,我們可以獲取所需的子元素。這裡顯示了 <div> 標籤索引為 1 的子元素。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.div

children = tag.children

childlist = [child for child in children if child not in ['\n', ' ']]

print (childlist[1])

輸出

<p>Python</p>

要使用 findChildren() 方法而不是 children 屬性,請將語句更改為

children = tag.findChildren()

輸出不會有任何變化。

定位第 n 個子元素的更有效方法是使用 select() 方法。select() 方法使用 CSS 選擇器從當前元素獲取所需的 PageElements。

Soup 和 Tag 物件透過其 .css 屬性支援 CSS 選擇器,該屬性是 CSS 選擇器 API 的介面。選擇器實現由 Soup Sieve 包處理,該包與 bs4 包一起安裝。

Soup Sieve 包定義了不同型別的 CSS 選擇器,即簡單、複合和複雜 CSS 選擇器,它們由一個或多個型別選擇器、ID 選擇器、類選擇器組成。這些選擇器在 CSS 語言中定義。